深度学习

全面整理30个重要的深度学习库:按Python和C++等10种语言分类

本文介绍了包括 Python、Java、Haskell等在内的一系列编程语言的深度学习库。

Python

- Theano 是一种用于使用数列来定义和评估数学表达的 Python 库。它可以让 Python 中深度学习算法的编写更为简单。很多其他的库是以 Theano 为基础开发的:

- Keras 是类似 Torch 的一个精简的,高度模块化的神经网络库。Theano 在底层帮助其优化 CPU 和 GPU 运行中的张量操作。

- Pylearn2 是一个引用大量如随机梯度(Stochastic Gradient)这样的模型和训练算法的库。它在深度学习中被广泛采用,这个库也是以 Theano 为基础的。

- Lasagne 是一个轻量级的库,它可以在 Theano 中建立和训练神经网络。它简单、透明、模块化、实用、专一而克制。

- Blocks 是一种帮助你在 Theano 之上建立神经网络模型的框架。

- Caffe 是一种以表达清晰、高速和模块化为理念建立起来的深度学习框架。它是由伯克利视觉和学习中心(BVLC)和网上社区贡献者共同开发的。谷歌的 DeepDream 人工智能图像处理程序正是建立在 Caffe 框架之上。这个框架是一个 BSD 许可的带有 Python 接口的 C++库。

- nolearn 包含大量其他神经网络库中的包装器和抽象(wrappers and abstractions),其中最值得注意的是 Lasagne,其中也包含一些机器学习的实用模块。

- Genism 是一个部署在 Python 编程语言中的深度学习工具包,用于通过高效的算法处理大型文本集。

- Chainer 连接深度学习中的算法与实现,它强劲、灵活而敏锐,是一种用于深度学习的灵活的框架。

- deepnet 是一种基于 GPU 的深度学习算法的 Python 实现,比如:前馈神经网络、受限玻尔兹曼机、深度信念网络、自编码器、深度玻尔兹曼机和卷积神经网络。

- Hebel 是一个在 Python 中用于带有神经网络的深度学习的库,它通过 PyCUDA 使用带有 CUDA 的 GPU 加速。它可实现大多数目前最重要的神经网络模型,提供了多种不同的激活函数和训练方式,如动量,Nesterov 动量,退出(dropout)和 前期停止(early stopping)。

- CXXNET 是一种快速,简明的分布式深度学习框架,它以 MShadow 为基础。它是轻量级可扩展的 C++/CUDA 神经网络工具包,同时拥有友好的 Python/Matlab 界面,可供机器学习的训练和预测使用。

- DeepPy 是一种建立在 Mumpy 之上的 Python 化的深度学习框架。

- DeepLearning 是一个用 C++和 Python 开发的深度学习库。

- Neon 是 Nervana 公司基于 Python 开发的深度学习框架。

C++

- eblearn 是一个机器学习的开源 C++库,由纽约大学机器学习实验室的 Yann LeCun 牵头研发。尤其是,按照 GUI、演示和教程来部署的带有基于能量的模型的卷积神经网络。

- SINGA 被设计用来进行已有系统中分布式训练算法的普通实现。它由 Apache Software Foundation 提供支持。

- NVIDIA DIGITS 是一个新的用于开发、训练和可视化神经网络系统。它把深度学习放进了基于浏览器的界面中,让数据分析师和研究人员可以快速设计最好的深度学习神经网络(DNN)来获取实时的网络行为可视化数据。

- Intel® Deep Learning Framework 为英特尔的平台提供了统一的框架来加速深度卷积神经网络。

Java

- N-Dimensional Arrays for Java (ND4J) 是一种为 JVM 设计的科学计算库。它们被应用在生产环境中,这就意味着路径被设计成可以最小的 RAM 内存需求来快速运行。

- Deeplearning4j 是第一个为 Java 和 Scala 编写的消费级开元分布式深度学习库。它被设计成在商业环境中使用,而非研究工具。

- Encog 是一种先进的机器学习框架,支持支持向量机(Support Vector Machines),人工神经网络(Artificial Neural Networks),基因编程(Genetic Programming),贝叶斯网络(Bayesian Networks),隐马尔科夫模型(Hidden Markov Models)和 遗传算法(Genetic Algorithms)。

JavaScript

- Convent.js 是一种 Javascript 中用于深度学习模型(主要是神经网络)的库。完全在浏览器中使用,不需要开发工具,不需要编译器,不需要安装,也不需要 GPU 的支持,简单易用。

Lua

- Torch 是一种科学计算框架,可支持多种计算机学习算法。

Julia

- Mocha 用于 Julia 的一种深度学习框架,其灵感来源于 C++框架 Caffe。在 Mocha 中通用的随机梯度求解器和公共层的有效实现可以被用于训练深度/浅层(卷积)神经网络,其带有通过(堆叠的)自动解码器的(可选的)无监督的预训练。其最大特点包括:带有模块化架构、 高层面的接口、便携性与速度、兼容性等等。

Lisp

- Lush(Lisp Universal Shell)是一种为研究人员、试验者以及对大规模数值和图形应用感兴趣的工程师设计的、面向对象的编程语言。它带有丰富的作为机器学习库一部分的深度学习库。

Haskell

- DNNGraph 是一个用 Haskell 编写的深度神经网络生成 DSL。

.NET

- Accord.NET 是一种.NET 机器学习框架,包含声音和图像处理库,它完全由 C# 编写。它是一种为开发生产级的计算机视觉、计算机听觉、信号处理和统计应用而设计的完整框架。

R

- darch 包可以用于建立多层神经网络(深层结构)。其中的训练方式包括使用对比发散法进行提前训练,或使用通常的训练方法(如反向传播和共轭梯度)进行一些微调。

- deepnet 实现了一些深度学习架构和神经网络算法,包括 BP、RBM、DBN、深度自编码器等等。

Node.js + React Native 毕设:农业物联网监测系统的开发手记

毕设大概是大学四年里最坑爹之一的事情了,毕竟一旦选题不好,就很容易浪费一年的时间做一个并没有什么卵用,又不能学到什么东西的鸡肋项目。所幸,鄙人所在的硬件专业,指导老师并不懂软件,他只是想要一个农业物联网的监测系统,能提供给我的就是一个Oracle 11d数据库,带着一个物联网系统运行一年所保存的传感器数据…That’s all。然后,因为他不懂软件,所以他显然以结果为导向,只要我交出一个移动客户端和一个服务端,并不会关心我在其中用了多少坑爹的新技术。

那还说什么?上!我以强烈的恶搞精神,决定采用业界最新最坑爹最有可能烂尾的技术,组成一个 Geek 大杂烩,幻想未来那个接手我工作的师兄的一脸懵逼,我露出了邪恶的笑容,一切只为了满足自己的上新欲。

全部代码在 GPL 许可证下开源:

由于数据库是学校实验室所有,所以不能放出数据以供运行,万分抱歉~。理论上应该有一份文档,但事实上太懒,不知道什么时候会填坑~。

总体架构

OK,上图说明技术框架。

该物联网监测系统整体上可分为三层:数据库层,服务器层和客户端层。

数据库和代码层

数据库层除了原有的Oracle 11d数据库以外,还额外增加了一个Redis数据库。之所以增加第二个数据库,原因为:

- Node.js 的 Oracle 官方依赖 node-oracledb 没有ORM,也就是说,所有的对数据库的操作,都是直接执行SQL语句,简单粗暴,我担心自己孱弱的数据库功底(本行是 Android 开发)会引发锁表问题,所以通过限制只读来避开这个问题。

- 由于该系统服务于农业企业的内部管理人员,因此其账号数量和总体数据量必然有限,因此使用 redis 这种内存型数据库,可以不必考虑非关系型数据库在容量占用上的劣势。读取速度反而较传统的 SQL 数据库有一定的优势。

- 使用非关系型数据库比关系型数据库好玩多了(雾

- 之所以写了右边的Git部分,是因为原本打算利用docker技术搞一个持续集成和部署的程序,实现提交代码=>自动测试=>更新服务器部署更新=>客户端自动更新 这样一整套持续交付的流程,然而最后并没有时间写。

服务器层

服务器层,采用 Node.js 的 Express 框架作为客户端的 API 后台。因为 Node.js 的单线程异步并发结构使之可以轻松实现较高的 QPS,所以非常适合 API 后端这一特点。其框架设计和主要功能如下图所示:

像网关层:鉴权模块这么装逼的说法,本质也就是app.use(jwt({secret: config.jwt_secret}).unless({path: ['/signin']}));一行而已。因为是直接从毕业论文里拿下来的图,毕业论文都这尿性你们懂的,所以一些故弄玄虚敬请谅解。

客户端层

客户端层绝大部分是 React Native 代码,但是监控数据的图表生成这一块功能(如下图),由于 React Native 目前没有开源的成熟实现;试图通过 Native 代码来画图表,需要实现一个 Native 和 React Native 互相嵌套的架构,又面临一些可能的困难;故而最终选择了内嵌一个 html 页面,前端代码采用百度的 Echarts 框架来绘制图表。最终的结构就是大部分 React Native + 少部分 Html5 的客户端结构。

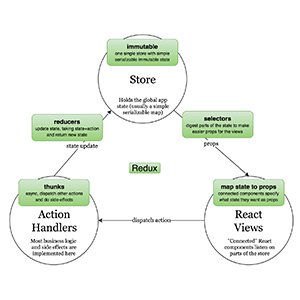

另外就是采用了 Redux 来统一应用的事件分发和 UI 数据管理了。可以说,React Native 若能留名青史,Redux 必定是不可或缺的一大原因。这一点我们后文再述。

细节详述

服务端层

服务端接口表:

服务端程序的编写过程中,往往涉及到了大量的异步操作,如数据库读取,网络请求,JSON解析等等。而这些异步操作,又往往会因为具体的业务场景的要求,而需要保持一定的执行顺序。此外,还需要保证代码的可读性,显然此时一味嵌套回调函数,只会使我们陷入代码几乎不可读的回调地狱(Callback Hell)中。最后,由于JavaScript单线程的执行环境的特性,我们还需要避免指定不必要的执行顺序,以免降低了程序的运行性能。因此,我在项目中使用Promise模式来处理多异步的逻辑过程。如下代码所示:

function renderGraph(req, res, filtereds) {

var x = [];

var ys = [];

var titles = [];

filtereds[0].forEach(function(row) {

x.push(getLocalTime(row.RECTIME));

});

filtereds.forEach(function(filtered){

if (filtered[0] == undefined)

// even if at least one of multi query was succeed

// fast-fail is essential for secure

throw new Error('数据库返回结果为空');

var y = [];

filtered.forEach(function(row) {

y.push(row.ANALOGYVALUE);

});

ys.push(y);

titles.push(filtered[0].DEVICENAME + ': ' + filtered[0].DEVICECODE);

});

res.render('graph', {

titles: titles,

dataX: x,

dataY: ys,

height: req.query.height == undefined ? 200 : req.query.height,

width: req.query.width == undefined ? 300 : req.query.width,

});

}

function resFilter(resolve, reject, connection, resultSet, numRows, filtered) {

resultSet.getRows(

numRows,

function (err, rows)

{

if (err) {

console.log(err.message);

reject(err);

} else if (rows.length == 0) {

resolve(filtered);

process.nextTick(function() {

oracle.releaseConnection(connection);

});

} else if (rows.length > 0) {

filtered.push(rows[0]);

resFilter(resolve, reject, connection, resultSet, numRows, filtered);

}

}

);

}

function createQuerySingleDeviceDataPromise(req, res, device_id, start_time, end_time) {

return oracle.getConnection()

.then(function(connection) {

return oracle.execute(

"SELECT\

DEVICE.DEVICEID,\

DEVICECODE,\

DEVICENAME,\

UNIT,\

ANALOGYVALUE,\

DEVICEHISTROY.RECTIME\

FROM\

DEVICE INNER JOIN DEVICEHISTROY\

ON\

DEVICE.DEVICEID = DEVICEHISTROY.DEVICEID\

WHERE\

DEVICE.DEVICEID = :device_id\

AND DEVICEHISTROY.RECTIME\

BETWEEN :start_time AND :end_time\

ORDER\

BY RECTIME",

[

device_id,

start_time,

end_time

],

{

outFormat: oracle.OBJECT,

resultSet: true

},

connection

)

.then(function(results) {

var filtered = [];

var filterGap = Math.floor(

(end_time - start_time) / (120 * 100)

);

return new Promise(function(resolve, reject) {

resFilter(resolve, reject,

connection, results.resultSet, filterGap, filtered);

});

})

.catch(function(err) {

res.status(500).json({

status: 'error',

message: err.message

});

process.nextTick(function() {

oracle.releaseConnection(connection);

});

});

});

}

function secureCheck(req, res) {

let qry = req.query;

if (

qry.device_ids == undefined

|| qry.start_time == undefined

|| qry.end_time == undefined

) {

throw new Error('device_ids或start_time或end_time参数为undefined');

}

if (req.query.end_time < req.query.start_time) {

throw new Error('终止时间小于起始时间');

}

};

router.get('/', function(req, res, next) {

try {

var device_ids;

var queryPromises = [];

secureCheck(req, res);

device_ids = req.query.device_ids.toString().split(';');

for(let i=0; i<device_ids.length; i++) {

queryPromises.push(createQuerySingleDeviceDataPromise(

req, res, device_ids[i], req.query.start_time, req.query.end_time));

};

Promise.all(queryPromises)

.then(function(filtereds) {

renderGraph(req, res, filtereds);

}).catch(function(err) {

res.status(500).json({

status: 'error',

message: err.message

});

})

} catch(err) {

res.status(500).json({

status: 'error',

message: err.message

});

}

});这是生成指定N个传感器在一段时间内的折线图的逻辑。显然,剖析业务可知,我们需要在数据库中查询N次传感器,获得N个值对象数组,然后才能去用N组数据渲染出图表的HTML页面。 可以看到,外部核心的Promise控制的流程只集中于下面的几行之中:Promise.all(queryPromises()).then(renderGraph()).catch()。即,只有获取完N个传感器的数值之后,才会去渲染图表的HTML页面,但是这N个传感器的获取过程却又是并发进行的,由Promise.all()来实现的,合理地利用了有限的机器性能资源。

然而,推入queryPromises数组中的每个Promise对象,又构成了自己的一条Promise逻辑链,只有这些子Promise逻辑链被处理完了,才可以说整个all()函数都被执行完了。子Promise逻辑链大致地可以总结为以下形式:

function() {

return new Promise().then().catch();

}其中的难点在于:

- 合理地切分整套业务逻辑到不同的then()函数中,且一个then()中只能有一个异步过程。

- 函数体内的异步过程所产生的新的Promise逻辑链必须被通过return的方式挂载到父函数的Promise逻辑链中,否则即可能形成一个有先有后的控制流程。

- catch()函数必须要做好捕捉和输出错误的处理,否则代码编写过程中的错误即不可能被发现,异步编程的整个过程也就无从继续下去了。

- 值得一提的是Promise模式的引入。Node.js 自身不带有Promise,可以引入标准的ECMAScript的Promise实现,然而其功能较为简陋,对于各种API的实现过于匮乏,因此最后选择了bluebird库来引入Promise模式的语言支持。

由此我们可以看到,没有无缘无故的高性能。Node.js 的高并发的优良表现,是用异步编程的高复杂度换来的。当然,你也可以选择不要编程复杂度,即不采用 Promise,Asnyc 等等异步编程模式,任由代码沦入回调地狱之中,那么这时候的代价就是维护复杂度了。其中取舍,见仁见智。

客户端层

客户端主要功能如下表所示:

接下来简单介绍下几个主要页面。可以发现 iOS 明显比 Android 要来的漂亮,因为只对 iOS 做了视觉上的细调,直接迁移到 Android 上,就会由于屏幕显示的色差问题,显得非常粗糙。所以,对于跨平台的 React Native App 来说,做两套色值配置文件,以供两个平台使用,还是很有必要的。

上图即是土壤墒情底栏的当前数据页面,分别在Android和iOS上的显示效果,默认展示所有当前的传感器的数值,可以通过选择传感器种类或监测站编号进行筛选,两个条件可以分别设置,选定后再点击查找,即向服务器发起请求,得到数据后刷新页面。由于React Native 的组件化设计,刷新将只刷新下侧的DashBoard部分,且,若有上次已经渲染过的MonitorView,则会复用他们,不再重复渲染,从而实现了降低CPU占用的性能优化。MonitorView,即每一个传感器的展示小方块,自上至下依次展示了传感器种类,传感器编号,当前的传感器数值以及该传感器显示数值的单位。MonitorView和Dashboard均被抽象为一个一般化,可复用的组件,使之能够被利用在气象信息、病虫害监测之中,提升了开发效率,降低了代码的重复率。

上图是土壤墒情界面的历史数据界面,分别在Android和iOS上的展示效果,默认不会显示数据,直到输入了传感器种类和监测站编号,选择了年月日时间后,再点击查找,才会得到结果并显示出来。该界面并非如同当前数据界面一样,Android和iOS代码完全共用。原因在于选择月日和选择时间的控件,Android和iOS系统有各自的控件,它们也被封装为React Native中不同的控件,因此,两条绿色的选择时间的按钮,被封装为HistoricalDateSelectPad,分别放在componentIOS和componentAndroid文件夹中。界面下侧的数据监测板,即代码中的Dashboard,是复用当前数据中的Dashboard。

上图是土壤墒情界面的图表生成界面,分别在Android和iOS上的展示效果。时间选择界面,查找按钮,选择框,均可复用前两个界面的代码,因此无需多提。值得说的是,生成的折线图,事实上是通过内嵌的WebView来显示一个网页的。图表网页的生成,则依靠的百度Echarts 第三方库,然后服务端提供了一个预先写好的前端模板,Express框架填入需要的数据,最后下发到移动客户端上,渲染生成图表。图表支持了多曲线的删减,手指选取查看具体数据点,放大缩小等功能。

上图则是实际项目应用中的Redux相关文件的结构。stores中存放全局数据store相关的实现。

actions中则存放根据模块切割开的各类action生成函数集合。在 Redux 中,改变 State 只能通过 action。并且,每一个 action 都必须是 Javascript Plain Object。事实上,创建 action 对象很少用这种每次直接声明对象的方式,更多地是通过一个创建函数。这个函数被称为Action Creator。

reducers中存放许多reducer的实现,其中RootReducer是根文件,它负责把其他reducer拼接为一整个reducer,而reducer就是根据 action 的语义来完成 State 变更的函数。Reducer 的执行是同步的。在给定 initState 以及一系列的 actions,无论在什么时间,重复执行多少次 Reducer,都应该得到相同的 newState。

性能测试

服务端

测试工具:OS X Activity Monitor(http_load)

客户端

iOS

测试工具:Xcode 7.3

Android

测试工具:Android Studio 1.2.0

代码量相关

简单总结

React Native 尽管在开发上具有这样那样的坑,但是因其天生的跨平台,和优于 Html5的移动性能表现,使得他在写一些不太复杂的 App 的时候,开发速度非常快,自带两倍 buff。

Draw animated chart on React Native

At Meguro.es #4 on June 21th, 2016, I talked about drawing animated chart on React Native. The talk was about the things I learned through developing an tiny app, Compare. It’s a super simple app to compare temperatures.

Before creating it, I had no idea about what temperatures on weather forecast, like 15 degrees Celsius, were actually like. I remember what yesterday was like, but not the numbers. Typical weather forecast apps shows only future temperatures without past records. Thanks to The Dark Sky Forecast API, the app fetches both of past records and future forecasts, and show them together.

The app’s source code is on GitHub:

There might have been some charting libraries to draw similar charts, but I like to write things from scratch. I like to reinvent the wheel especially when it’s a side project. Thanks to that, I found a way to animate smooth paths with the Animated library.

If I have to add something to the slides:

- It’s fun to develop on React Native, and super easy to start. If you know React and CSS, you can apply your familiar ideas to mobile app development. And they are actually powerful.

- Jason Brown’s JavaScript without Grammar is an awesome blog. It has lots of articles about React Native and animation on it, which taught me a lot. Also, I found the awesomeness of

LayoutAnimationat Justin Poliachik’s React Native’s LayoutAnimation is Awesome, which is a great post too.

Home automation with cheap 433MHz plugs, a 1$ 433MHz transmitter, and a TP-Link TL-WR703N router

Home automation with cheap 433MHz plugs, a 1$ 433MHz transmitter, and a TP-Link TL-WR703N router

By JC on Saturday 22 October 2016, 17:42 – Hacking – Permalink

Two years ago, I started playing around with cheap 433MHz plugs that can be found almost everywhere. At that time, I got several from different brands, from the well known Chacon Di-O plugs, to the most obscure chinese/no-name ones, and my goal was to reverse engineer as much protocols as possible. I compiled the result into a little tool I called rf-ctrl (now available on my GitHub), and forgot about it. However, this summer, I needed to find a solution to remotely control my electric heaters (not because I was cold obviously, but because I had the time to do it), and thought it was time to dig up rf-ctrl with a bit of polishing (a Web UI called Home-RF).

ON/OFF Keying (OOK)

Let’s first talk about OOK a little bit. Most of the cheap 433MHz plugs (but also chimes, rolling shutter controllers, thermometers …) use the ON/OFF Keying or OOK modulation. The idea is that data are sent in binary form, by alternatively enabling and disabling the transmitter, thus the carrier frequency. I found mainly two ways of doing so:

- coding a 0 with an ON/OFF transition that has particular ON and OFF durations, and coding a 1 with another ON/OFF transition that has other particular ON and OFF durations

Most of the plugs I found use this scheme, and this is the kind of modulation that rf-ctrl implements. This technique, which could be seen as some kind of Manchester code, allows the receiver to easily recover the clock and sync, since the carrier frequency cannot be enabled or disabled longer than a particular amount of time. The timings for a 0 are often inverted compared to those of a 1, for instance, 160µs-ON/420µs-OFF represents a 0 with the OTAX protocol, while 420µs-ON/160µs-OFF represents a 1. However, this is not systematic, and some protocols use totally different timings, for instance 260µs-ON/260µs-OFF for a 0 and 260µs-ON/1300µs-OFF for a 1 with the Di-O protocol. The data part of the frame is sometimes encapsulated between a starting marker and an ending marker. These markers are also represented with an ON/OFF transition, but with different timings. The whole frame is then repeated a specific number of times, with a delay between the frames that can also be assimilated to either a starting marker without ON state, or an ending one with a long OFF state. Last thing to note is the transition order which is often ON/OFF, but can be OFF/ON as well.

- coding a 0 by disabling the carrier frequency for a time Tb, and coding a 1 by enabling it for the same time Tb

This is actually the “real” low-level way of doing OOK things. You can even describe the previous one that way by choosing a bit-rate (1/Tb) high enough to represent the previous ON/OFF transitions by a succession of ones and zeros that will match the timings. This kind of coding is rather found in high-end devices, like old car keys and more secure plugs/rolling shutters. It was not compatible with the HE853 dongle I had at that time, and thus is not supported by rf-ctrl. However I played with it at a point in order to control the rolling shutters and plugs from the Somfy brand, and to test TI’s CC110x transceiver, but that’s not the purpose of this post.

Reversing the protocol of a 433MHz plug

To replicate a protocol, one must understand two things. The OOK timings (physical characteristics) is the first one and the easiest, while the actual data format of the frame will be the second one.

OOK timings

The easiest way to capture a frame is to use a 1$ 433MHz (433,92Mhz actually) receiver connected to either an oscilloscope or a digital analyzer. You will get something like this (Sumtech protocol):

But if you do not have this kind of receiver but have an oscilloscope laying around, you can also use a simple wire of around 17 cm (= 3×10^8/(4x433x10^6) = lambda/4) connected to one of the inputs ! You will get something like this, which is enough to understand the underlaying timings (Idk protocol this time):

But if you do not have this kind of receiver but have an oscilloscope laying around, you can also use a simple wire of around 17 cm (= 3×10^8/(4x433x10^6) = lambda/4) connected to one of the inputs ! You will get something like this, which is enough to understand the underlaying timings (Idk protocol this time):

Thanks to this, you can measure the expected timings and the number of times the frame needs to be repeated. It’s time to start writing down zeros and ones on a sheet of paper.

Frame format

Now, what remains is the actual data to send. Most of the time, a frame consists of a remote ID which is the ID of the remote that sends the frame, a device ID which is just the number of the button pressed on the remote, an action, like ON or OFF, which is most likely 1 or 0, some kind of checksum, and some fixed values. In some cases there are additional values that change every time a button is pressed. They are called rolling codes, and are found in brands like Somfy. This kind of codes are often harder to reverse, but the cheap plugs do not use that . Finally, some protocols add a simple obfuscation layer on top of the frame, like a XOR for instance.

. Finally, some protocols add a simple obfuscation layer on top of the frame, like a XOR for instance.

To understand a protocol, the best method remains to gather as much frames as possible, while writing down what generated them. The first step is to determine if two frames generated by pushing the same button are indeed the same. It will most likely be the case, but if not, you need to find out which part of the frame changes. It can be a simple counter, or something more clever. Remember that if there is some kind of encryption/obfuscation, the whole frame can change because of a simple counter. Anyway, you need to scratch your head and find the solution by comparing as much frames as possible.

Assuming all frames generated by one button are the same, the next thing to do is to change one parameter at a time, and look at the result to identify the different fields. For instance, press the ON and OFF button of the same plug number, on the same remote, and compare the resulting frames. Only a small part of it should change, part that you can now identify as the action field.

Then press the ON button for another plug, and compare to the ON button for the first plug. Check that 1) the action field remains the same, 2) something else changed. This something else is probably the device ID. You can then try to open the remote, and look for some kind of multi-switch or jumpers. You will not necessarily find something in all remotes since some will have their ID stored in an Eeprom or something like that, but if you do find something, try to change it and check the generated frames. This will most likely help to find the remote ID.

If you see a part of the frame that seems to change only when something else changes, then you might just have identified a checksum. Try to find how these bits can be computed from the other ones. It can be a for instance a simple sum, or a XOR. Repeat the procedure until you are convinced that all those fields behave as assumed.

Now, keep in mind this is just a generic description of a 433MHz device. Some will not fit the mold and might have, for instance, more or less fields. The frame format can even be completely different.

Once the frame format understood, it’s time to test ! For this you will need a 433MHz transmitter. I first used this HE853 USB dongle, which works fine with a regular PC, but I found out it was easier to just use this 1$ transmitter connected to a Raspberry PI, a TP-Link TL-WR703N router, or any device that offers GPIOs. And this is where rf-ctrl comes in handy. It uses a back-end/front-end (transmitter driver/protocol driver) logic allowing to implement new protocols easily. Here is how to do so:

- copy an existing protocol like auchan.c as <my_protocol>.c and add it to the Makefile by appending <my_protocol>.o to the

OBJECTSvariable - fill in the

timing_configstructure with the values you measured (values are expected in µs) - implement the

int (*format_cmd)(uint8_t *data, size_t data_len, uint32_t remote_code, uint32_t device_code, rf_command_t command);function which is supposed to generate the final frame in the pre-allocated*dataarray ofdata_lenbytes from the remote ID, the device ID and the command. - fill in the

rf_protocol_driverstructure with a short and long name for the protocol, the pointer to theformat_cmd()function and to thetiming_configstructure, the max allowed remote and device IDs, and the actual parameters this protocol needs (most likelyPARAM_REMOTE_ID | PARAM_DEVICE_ID | PARAM_COMMAND)

That’s all ! You should be able to build rf-ctrl and control your plug with it. If it does not work, do not hesitate to check the generated signal with your oscilloscope or digital analyzer.

Controlling my electric heaters remotely

Let’s get back to the main topic. To control my heaters, I thought I would buy plugs from one of the brands I already reversed, and went to buy the “auchan” ones. Unfortunately, they were still selling 433MHz plugs under the same name, but the underlaying supplier had clearly changed. I decided to buy three of them anyway, but knew I would have to reverse yet another protocol, with the risk it might have used some kind of rolling codes… Hopefully, it did not, and was pretty straightforward to understand. For your information it’s the protocol I called “auchan2”.

Now regarding the actual setup, I used the well known TP-Link TL-WR703N router running OpenWrt and a 1$ 433MHz transmitter (again, like this one) connected, through a 2V -> 5V level shifter, to the GPIO 7 of the router. I wrote the needed Makefile to build rf-ctrl as an OpenWrt package, and also created a kernel driver that generates the proper OOK signal on GPIO 7 once fed with the correct timings and data. This driver, called ook-gpio, is directly provided as an OpenWrt package on my GitHub. Since the WR703N does not have much free space, I chose to build a special firmware for it with everything in it, removing what was useless. Once the firmware flashed, I verified that I was indeed able to control my heaters. But to do that remotely, I had to connect trough SSH and use my command line tool, which looked like something that could have been improved. So I made a little Web UI called Home-RF, which is a little shell script that allows to control rf-ctrl by generating a web page with configurable presets. It looks like this:

The idea is that you can add presets for devices like plugs, rolling shutters or chimes, and they will be displayed like a remote. As a bonus, It also supports WakeOnLan compatible computers (usingetherwake). There is a simple preset editor included in the interface, as well as an advanced panel that allows to manually control rf-ctrl or etherwake. Home-RF will be nicely displayed on a PC, as well as on mobile phones. It is available here on my GitHub, and can be built as an OpenWrt package.

At that point, I rebuilt a firmware with Home-RF inside, and flashed it. I’m using a VPN at home, so I do not care about authentication directly in Home-RF. However, if you plan to use it remotely, do not forget to add some kind of access control on top of it (htaccess, SSH, VPN…) !

How-to do the same

In order to build your own RF gateway, you will need:

- a TP-Link TL-WR703N router that you can find here for instance

- a 5V 433MHz transmitter like this one

- an N-MOSFET in enhancement mode with a threshold voltage smaller than 2V for the level shifter (I used this BSS138)

- one 10k Ohm resistor

- a 17,3cm long wire for the antenna

- a 3 pins female connector with 2.54mm pitch (optional)

- a piece of prototyping PCB

- some wire

- some Kapton

The provided instructions assume you are working on a PC running Linux.

First, the hardware

The schematic for the level shifter is the following:

– Solder the MOSFET and the resistor to match the schematic above

– Use one pad of the PCB as Ground, and solder three wires on Output, +5V Transmitter, and GND Transmitter

– Either solder the 3 pins connector to the other end of the wires, or solder the RF transmitter directly (remove the male pins of the transmitter if any)

– Open the WR703N router, and look for the four signals below:

- Gnd is on a little pad, top side of the PCB

- GPIO 7 is on R15, top side of the PCB

- +2V is on C47 (or TP2V0), bottom side of the PCB

- +5V is on R113, bottom side of the PCB

– Solder one end of four wires on these signals, and the other end to the level shifter previously made

– Solder the 17,3 cm long wire to the antenna pad of the transmitter and put Kapton everywhere to prevent any short-circuit (I tried without antenna at first, that’s why it is missing on my picture)

– Put the board back in its casing, use its reset hole to get the antenna out of it (you will have to bend the antenna to do so, so make sure it does not push the reset button), and close it

You should get something like this:

Now, the software

I attached a prebuilt Barrier Breaker (14.07) OpenWrt firmware with all the tools in it, but it is funnier to build it yourself:

– Create your root folder for the build, for instance my-gateway:

$ mkdir my-gateway

– Go to that folder, and checkout a Barrier Breaker OpenWrt tree (I did not try Chaos Calmer, so let me know if it works):

$ cd my-gateway

$ git clone -b barrier_breaker git://github.com/openwrt/openwrt.git

– Checkout rf-ctrl, Home-RF and ook-gpio:

$ git clone https://github.com/jcrona/rf-ctrl.git

$ git clone https://github.com/jcrona/home-rf.git

$ git clone https://github.com/jcrona/ook-gpio.git

– Create the packages folders in OpenWrt:

$ mkdir -p openwrt/package/utils/home-rf/files

$ mkdir -p openwrt/package/utils/rf-ctrl/src

$ mkdir -p openwrt/package/kernel/ook-gpio

– Copy the packages content:

$ cp -a home-rf/www openwrt/package/utils/home-rf/files/

$ cp home-rf/OpenWrt/Makefile openwrt/package/utils/home-rf/

$ cp rf-ctrl/* openwrt/package/utils/rf-ctrl/src/

$ cp rf-ctrl/OpenWrt/Makefile openwrt/package/utils/rf-ctrl/

$ cp -a ook-gpio/* openwrt/package/kernel/ook-gpio/

– Update external feeds in OpenWrt and add etherwake to the build system:

$ cd openwrt

$ ./scripts/feeds update -a

$ ./scripts/feeds install etherwake

– Download the attached home-rf_openwrt.config into the my-gateway folder, and use it:

$ cp ../home-rf_openwrt.config .config

$ make oldconfig

– Build the OpenWrt firmware

$ make

– You should have your firmware ready in my-gateway/openwrt/bin/ar71xx/.

If you have any issue buidling the mac80211 package, it might be because the build system failed to clone the linux-firmware Git. In that case, download the linux-firmware-2014-06-04-7f388b4885cf64d6b7833612052d20d4197af96f.tar.bz2 archive from here, copy it into the my-gateway/openwrt/dl/ folder, and restart the build.

Now, you need to flash your WR703N router. If you never flashed OpenWrt before on your router, use openwrt-ar71xx-generic-tl-wr703n-v1-squashfs-factory.bin as explained here. Otherwise, use openwrt-ar71xx-generic-tl-wr703n-v1-squashfs-sysupgrade.bin with the sysupgrade tool.

Final touch

At that point, you should have your router up and running. You still need to configure it like a regular OpenWrt router, as explained here. You can, for instance, configure it in WiFi station mode, so that you can find the best place to reach all your 433MHz devices.

Once properly configured, open a browser and go to http://<your_router_ip>/home-rf. If everything went well, you will get the Home-RF interface ready to be configured !

Final words

So now I’m able to control my electric heaters from my phone for around 20$, and I hope you will be able to do the same with your own 433MHz devices. All the discussed tools are available on myGitHub. I will be happy to extend the list of supported protocols in rf-ctrl, so feel free to add more.

If you want to play around, try the “scan” mode of rf-ctrl ! It allows to send all possible frames within a range of given remote IDs, device IDs, and protocols.

That’s all for now !

Attachments

Recovering 433MHz Messages with RTL-SDR and MATLAB

Recovering 433MHz Messages with RTL-SDR and MATLAB

Posted 2015/02/13. Last updated 2015/02/17.

Introduction

I recently bought a DVB-T dongle containing the Realtek RTL2832U and Raphael Micro R820T chips with the intent to use it as a Software-Defined Radio (SDR) receiver. These dongles are incredible because for about $10, you can tune in to frequencies between 24 and 1766MHz and listen to a wide range of devices and signals, provided you have a proper antenna (and a down-/up- converter if you want to listen outside of this range). The device, pictured below, is truly very simple: the back consists solely of a couple lines that could probably not be routed on the top layer of the PCB.

As a first project, I decided to look into the 433MHz frequency, as others have also successfully done (see here, here, and here for instance), but decided to focus on the methodology and the tools available, rather than recovering a specific device’s key, since I didn’t have one lying around. This post describes the manual process I followed with existing tools, as well as a basic MATLAB script that I wrote interfacing with the RTL device which automates the binary signal recovery process.

UPDATE: There is some good discussion of this post going on at Hackaday, RTL-SDR, and Reddit, which also contain a few more pointers for this kind of thing. My response to some of the points raised can be found here. A good alternative to MATLAB which I had not considered is Octave, which apparently interfaces well with GNU Radio.

Setup

As mentioned above, I did not have a device transmitting at 433MHz, so instead I used a typical cheap MX-FS-03V RF transmitter (pictured below) bought off of EBay, connected to an Arduino Uno. I used the rc-switch library, which appears to be pretty popular, with a lot of forks on GitHub. My code‘s loop simply calls mySwitch.send("010010100101") followed by a delay of 1 second and makes no other calls to the library besides enabling transmission on the appropriate Arduino pin.

The goal of the project was to uncover the details of the protocol (and the value transmitted) before looking at the library code to verify it. To this end, I installed SDR# to visualize and record the signal, as well as Audacity to inspect the produced WAV file. I additionally installed the rtl-sdr and rtl_433 libraries which contain command-line utilities for automation (Windows binaries can be found here and here).

Tuning In

Having programmed the Arduino and left it to constantly transmit, my first step was to fire up SDR# to visually inspect the signal. The figures below show SDR#’s spectrum analyzer and waterfall graphs centered at 433MHz. The spectrum analyzer shows a consistent noise level across frequencies when the transmitter is silent, and also indicates a few DC bias spikes. Moreover, the waterfall illustrates that the transmitter output is not filtered and produces noise/energy across many unwanted frequencies. [UPDATE: Per a suggestion here, reducing the gain helps remove the aliases, but does not entirely eliminate them.]

This can be seen even more clearly below, when a transmission is occurring, where we can also identify that the strongest signal is actually at 434MHz.

Analyzing the Signal

After selecting the frequency, I recorded 10 seconds of the signal which came out as an astonishingly large 110MB WAV file! Opening up the recording on Audacity, as shown below, we can identify 10 seemingly identical, equally spaced transmissions 1 second apart, with the exception of the 8th one.

We ignore the anomaly for now (as a closer inspection indicates it is simply truncated, but otherwise the same as other transmissions), and focus on an individual section:

Once more we find 10 identical transmissions within each section, so zooming further we can clearly identify the modulation as a type of on-off keying (OOK) where 0s are short HIGH bursts followed by long periods of silence, and 1s are long HIGH bursts followed by small periods of silence.

Note of course that the encoding could be reversed, but it is reasonable to assume that it is not (and our knowledge of what is being transmitted tells us we are right!): the signal appears to be 0100101001010. This is indeed what we transmitted, but there is a spurious 0 at the end. Though this could be a checksum, flipping the last bit or removing it does not alter the value, hence we can assume it is simply an End-of-Message (EOM) value. Looking at the individual signals for 0 and 1, we see that the pulse length for a 0 is 350μs long, and it is 3 times as long for a 1.

Looking at the setup code, we see that the pulse length is indeed 350μs long, and each message is repeated 10 times, each of which is followed by a sync message. Moreover, for the default protocol, a 0 is represented as 1 HIGH, 3 LOWs, while a 1 is the reverse. Success!

Recovering the Transmission with MATLAB

Even though rtl_433 readily decodes this message for us, when I found out that MATLAB has a package for RTL-SDR (which needs the Communications System Toolbox), I thought I’d try it out. As a first step, I tried the spectrum analyzer example, just to ensure that everything works. 433.989MHz gave the strongest signal, and behaves as expected both during silence and transmission:

The data is output in I/Q format with values between -1 and 1, but I did not want to write a demodulator, so I instead took the real part, corresponding to the in-phase component, which proves to be sufficient for our purposes. [UPDATE: An alternative is taking the modulus of the complex value. This has the added benefit of not needing the Hilbert transform below, asthis comment mentions. I can confirm that setting rdata = abs(data); and binary(smoothed >= high_thres) = 1; in the code works without further changes.] As can be seen in the figure below and left, the output is very noisy, so I immediately applied a Savitzky-Golay filter, which was chosen to be cubic for data frames of length 41, as in the MATLAB example. As the picture below and to the right shows, the filtering is very effective.

Having reduced the noise, the next step was to calculate the envelope of the signal, which in MATLAB is implemented by taking the modulus of the Hilbert transform, as also explainedhere. The figures below show what that looks like for the overall signal, as well as for a specific transmission of our 10 bits. As can be seen, during the transmission the envelope fluctuates a bit, but is most frequently above 1. When the transmission is not occurring, the value remains below 0.1, but this is not pictured here.

The conversion to a binary signal is straightforward: if the magnitude of the above quantity is above 0.5, the signal is considered to be at a logical HIGH, and if it is below 0.5 it is a logical LOW. Zooming into one of the transmissions shows us that the digital pulse produced is as expected, without noise:

The basic idea to automatically detect whether a signal is a 0 or 1 is simple: count the number of consecutive samples that were HIGH, and if they are close to the transmission pulse length of a 0 or a 1, print that value! There were a few intricacies in debouncing (where the code basically skips over a few LOWs in between HIGHs) and in setting the appropriate thresholds for what counts as “close enough”, but in the end the code was able to accurately recover all transmitted bits. That said, I expect that changes to the parameters will need to be made for other hardware, depending on factors such as the antennas and power of transmission.

Conclusion

RTL-SDR definitely opens up many possibilities. Even though this post was a “toy example”, it has real-world implications as plenty of devices operate freely at 433MHz and other frequencies, as explained in the introduction. Although MATLAB is not always easy to work with, it has tremendous capabilities, and the fact that it interfaces with the dongle is a great feature.

I believe that the RTL-SDR community would greatly benefit from more open-source projects using MATLAB, so I have made my code availabe on GitHub, if you would like to try it out for yourself. As mentioned above, it might need some tweaking based on your hardware, but I hope such changes will be minimal. If you have any comments or improvements, feel free tocontact me!

Postscript

My initial plan was to use GNU Radio on my new Raspberry Pi 2, but despite its extra processing power, I found that it could not adequately do signal processing, even for FM frequencies, and often underflowed. If you are interested in going down that route, you might want to look at this post containing installation instructions, and gqrx as a *nix alternative to SDR# (it’sgqrx-sdr under the repositories). Also take a look at this forum discussion if you get a BadMatch error, and at this post detailing how to approach the analysis using GNU Radio. Finally, if you, like me, don’t have an Ethernet plug available, but have an Android phone that can tether (even if it is using Wi-Fi), connect it to your Pi’s USB, set the connection mode to “Media” and follow the instructions here!

【资源帖】深度学习视觉领域常用数据集汇总

[导读] “大数据时代”,数据为王!无论是数据挖掘还是目前大热的深度学习领域都离不开“大数据”。大公司们一般会有自己的数据,但对于创业公司或是高校老师、学生来说,“Where can I get large datasets open to the public?”是不得不面对的一个问题。

Flickr数据集中挑选出的100万图像集。

Flickr的一个子集,包含100万的图像集。

Flickr中的27万的图像集。

机器标注的一个超大规模数据集,包含2亿图像。

包含13万的图像的数据集。

包含100万的图像,23000视频;微软亚洲研究院出品,质量应该有保障。

刘念宏:清华大学微电子系在读硕士研究生,清华大学“大数据硕士”,现任清华大学学生大数据协会会长。 主要研究方向:深度学习图像检测。 联系方式: lnh15@mails.tsinghua.edu.cn。

付睿:清华大学自动化系在读硕士研究生,清华大学“大数据硕士”,前任清华大学学生大数据协会会长。 主要研究方向:智能交通。 联系方式:freefor_ever@163.com。

Mirai物联网僵尸攻击深度解析

Mirai物联网僵尸攻击深度解析

有的厂商将Mirai命名为蠕虫不是很贴切,Mirai利用类似蠕虫的方式感染(与传统蠕虫感染方式不同),但实际上是一款僵尸程序。因而称之为Mirai僵尸蠕虫更为准确,后文主要以僵尸称呼。

美国大面积的网络瘫痪事件

2016年9月30日,黑客Anna-senpai公开发布Mirai僵尸源码。其公布源码的目的一则是发现有关机构正在清理其掌控的僵尸设备;二则是为了让更多的黑客使用该僵尸进行扩散,掩人耳目,隐藏自己的踪迹。

2016年10月21日,美国东海岸地区遭受大面积网络瘫痪,其原因为美国域名解析服务提供商Dyn公司当天受到强力的DDoS攻击所致。Dyn公司称此次DDoS攻击涉及千万级别的IP地址(攻击中UDP/DNS攻击源IP几乎皆为伪造IP,因此此数量不代表僵尸数量),其中部分重要的攻击来源于IOT设备,攻击活动从上午7:00(美国东部时间)开始,直到下午1:00才得以缓解,黑客发动了三次大规模攻击,但是第三次攻击被缓解未对网络访问造成明显影响。

此次攻击是一次跨越多个攻击向量以及互联网位置的复杂攻击,Flashpoint与Akamai的分析确认攻击流量的来源之一是感染了Mirai僵尸的设备,因为部分离散攻击IP地址来自Mirai僵尸网络。

Mirai僵尸在黑客Anna-senpai公布源码后,被黑客利用并快速的形成了大量的僵尸网络,其中部分黑客参与了此次攻击,目前不排除黑客Anna-senpai也参与了本次攻击,其拥有大概30万-40万的Mirai僵尸肉鸡。

启明星辰ADLab分析发现,Mirai僵尸借鉴了QBOT的部分技术,并在扫描技术、感染技术等方面做了优化,大大提升了感染速度。

Mirai僵尸重要事件回溯

此次针对Dyn域名服务器的攻击让古老的DDoS技术再一次震撼了互联网,其中最引人注目是物联网僵尸网络的参与,物联网概念流行了近7年,大量的智能设备正不断地接入互联网,其安全脆弱性、封闭性等特点成为黑客争相夺取的资源。目前已经存在大量针对物联网的僵尸网络,如QBOT、Luabot、Bashlight、Zollard、Remaiten、KTN-RM等等,并且越来越多的传统僵尸也开始加入到这个物联网行列中。

通过启明星辰ADLab的调查分析,Mirai僵尸网络有两次攻击史,其中一次是针对安全新闻工作者Brian Krebs的网站,攻击流量达到665Gbps。

另一次是针对法国网站主机OVH的攻击,其攻击流量达到1.1Tbps,打破了DDoS攻击流量历史记录。

Mirai僵尸重要事件回顾:

(1)2016年8月31日,逆向分析人员在malwaremustdie博客上公布mirai僵尸程序详细逆向分析报告,此举公布的C&C惹怒黑客Anna-senpai。

(2)2016年9月20日,著名的安全新闻工作者Brian Krebs的网站KrebsOnSecurity.com受到大规模的DDoS攻击,其攻击峰值达到665Gbps,Brian Krebs推测此次攻击由Mirai僵尸发动。

(3)2016年9月20日,Mirai针对法国网站主机OVH的攻击突破DDoS攻击记录,其攻击量达到1.1Tpbs,最大达到1.5Tpbs

(4)2016年9月30日,Anna-senpai在hackforums论坛公布Mirai源码,并且嘲笑之前逆向分析人员的错误分析。

(5)2016年10月21日,美国域名服务商Dyn遭受大规模DDoS攻击,其中重要的攻击源确认来自于Mirai僵尸。

在2016年10月初,Imperva Incapsula的研究人员通过调查到的49,657个感染设备源分析发现,其中主要感染设备有CCTV摄像头、DVRs以及路由器。根据这些调查的设备IP地址发现其感染范围跨越了164个国家或地区,其中感染量最多的是越南、巴西、美国、中国大陆和墨西哥。

直到2016年10月26日,我们通过Mirai特征搜索shodan发现,当前全球感染Mirai的设备已经超过100万台,其中美国感染设备有418,592台,中国大陆有145,778台,澳大利亚94,912台,日本和中国香港分别为47,198和44,386台。

在该地图中颜色越深,代表感染的设备越多,可以看出感染Mirai最多的几个国家有美国、中国和澳大利亚。

Mirai源码分析

Mirai源码是2016年9月30日由黑客Anna-senpai在论坛上公布,其公布在github上的源码被star了2538次,被fork了1371次。

Mirai通过扫描网络中的Telnet等服务来进行传播,实际受感染的设备bot并不充当感染角色,其感染通过黑客配置服务来实施,这个服务被称为Load。黑客的另外一个服务器C&C服务主要用于下发控制指令,对目标实施攻击。

通过我们对僵尸源码的分析发现,该僵尸具备如下特点:

(1)黑客服务端实施感染,而非僵尸自己实施感染。

(2)采用高级SYN扫描,扫描速度提升30倍以上,提高了感染速度。

(3)强制清除其他主流的IOT僵尸程序,干掉竞争对手,独占资源。比如清除QBOT、Zollard、Remaiten Bot、anime Bot以及其他僵尸。

(4)一旦通过Telnet服务进入,便强制关闭Telnet服务,以及其他入口如:SSH和web入口,并且占用服务端口防止这些服务复活。

(5)过滤掉通用电气公司、惠普公司、美国国家邮政局、国防部等公司和机构的IP,防止无效感染。

(6)独特的GRE协议洪水攻击,加大了攻击力度。

Mirai感染示意图:

上图简单显示了Mirai僵尸的感染过程,与普通僵尸感染不同的是,其感染端是通过黑客服务端实施的,而不是靠bot来实施感染。

受感染的设备端的 bot程序通过随机策略扫描互联网上的设备,并会将成功猜解的设备用户名、密码、IP地址,端口信息以一定格式上传给sanListen,sanLiten解析这些信息后交由Load模块来处理,Load通过这些信息来登录相关设备对设备实施感染,感染方式有echo方式、wget方式和tftp方式。这三种方式都会向目标设备推送一个具有下载功能的微型模块,这个模块被传给目标设备后,命名为dvrHelper。最后,dvrHelper远程下载bot执行,bot再次实施Telnet扫描并进行密猜解,由此周而复始的在网络中扩散。这种感染方式是极为有效的,Anna-senpai曾经每秒会得到500个成功爆破的结果。

bot分析

bot是mirai僵尸的攻击模块,其主要实现对网络服务设备(扫描过程不只针对IOT设备,只要开启Telnet服务的网络设备均不会放过)的Telnet服务的扫描并尝试进行暴力破解,其会将成功破解的设备ip地址、端口、用户名、密码等信息发送给黑客配置的服务器。并且同时接收C&C服务器的控制命令对目标发动攻击。

1、IOT设备防重启

由于Mirai的攻击目标主要设计来针对IOT设备,因此其无法将自身写入到设备固件中,只能存在于内存中。所以一旦设备重启,Mirai的bot程序就会消失。为了防止设备重启,Mirai向看门狗发送控制码0×80045704来禁用看门狗功能。

通常在嵌入式设备中,固件会实现一种叫看门狗(watchdog)的功能,有一个进程会不断的向看门狗进程发送一个字节数据,这个过程叫喂狗。如果喂狗过程结束,那么设备就会重启,因此为了防止设备重启,Mirai关闭了看门狗功能。这种技术常常被广泛应用于嵌入式设备的攻击中,比如曾经的海康威视漏洞(CVE-2014-4880)攻击代码中就采用过这种防重启技术。

这里有个小插曲,2016年8月31日,一位逆向分析人员将此代码判定错误,认为这是为了做延时而用,黑客Anna-senpai在Hackforums论坛公布源码时嘲笑并斥责了该逆向分析人员的错误。

2、进程名隐藏

Mirai为了防止进程名被暴露,在一定程度上做了隐藏,虽然这种隐藏并不能起到很好的作用。Mirai的具体做法是将字符串进行了随机化。

3、防止多实例运行

Mirai同大多数恶意代码一样,需要一种互斥机制防止同一个设备多个实例运行。但Mirai采用的手段有所不同,其通过开启48101端口来防止多个实例运行,具体做法是通过绑定和监听此端口,如果失败,便会关闭已经开启此端口的进程确保只有一个实例运行。这个特点是检测网络设备中是否存在Mirai的最高效的检测方法。

4、重绑定技术防止外来者抢占资源

Mirai有一个特点就是具有排他性,设备一旦感染,其会通过端口来关闭Telnet(23)、SSH(22,编译时可选删除项)、HTTP(80,编译时可选删除项)服务并且会阻止这些服务进行重启,其主要实现方法是通过kill强制关闭这三个服务进程,并强行占用这些服务开启时所需要的端口。此举Mirai既可以防止设备被其他恶意软件感染,也可以防止安全人员从外部访问该设备,提高Mirai的取证难度。此功能实现在killer.c文件中。

Telnet服务的重绑定实现如下图,SSH和HTTP服务采用类似的方式实现。

SSH服务的重绑定实现:

HTTP服务的重绑定实现:

通过对实际样本的分析我们发现,大部分黑客并没有对SSH和HTTP进行重绑定操作,绝大部分都只针对于Telnet服务进行了重绑定。

5、干掉竞争对手,独占资源

Mirai会通过一种 memory scraping的技术干掉设备中的其他恶意软件,其具体做法是搜索内存中是否存在QBOT特征、UPX特征、Zollard蠕虫特征、Remaiten bot特征来干掉对手,以达到独占资源的目的。

此外,Mirai如果发现anime恶意软件,同样也会强行干掉它。

6、可感染设备探测

Mirai僵尸随机扫描网络中IOT设备的Telnet服务并通过预植的用户名密码进行暴力破解,然后将扫描得到的设备IP地址、端口、设备处理器架构等信息回传给Load服务器。这里要注意的是,Mirai的随机扫描是有一个过滤条件的,其中比较有意思就是他会过滤掉通用电气公司、惠普公司、美国国家邮政局、国防部等公司和机构的IP地址。

Mirai僵尸中内置有60余个用户名和密码,其中内置的用户名和密码是加密处理过的,加密算法是通过简单的单字节多次异或实现,其密钥为0xDEADBEEF, 解密密钥为0xEFBEADDE。

Mirai使用高级SYN扫描技术对网络中的设备进行扫描破解,其速度较僵尸程序QBOT所采用的扫描技术快80倍,资源消耗减少至少达20倍。因此具备强大的扫描感染能力,黑客在收集肉鸡过程中,曾经每秒可新增500个IOT设备。

Telnet服务扫描实现如下:

当Mirai扫描到Telnet服务时,会连接Telnet并进行暴力登录尝试。Mirai首先会使用内置的用户名和密码尝试登录,之后通过发送一系列命令来判定登录成功与否。如果成功则试图进行一些操作,比如开启shell等操作,其发送的命令被初始化在一个Table中,如下表所示:

| 命令操作类型 | Index | 有效 | 功能描述 |

|---|---|---|---|

| TABLE_SCAN_CB_DOMAIN | 18 | yes | domain to connect to |

| TABLE_SCAN_CB_PORT | 19 | yes | Port to connect to |

| TABLE_SCAN_SHELL | 20 | yes | ‘shell’ to enable shell access |

| TABLE_SCAN_ENABLE | 21 | yes | ‘enable’ to enable shell access |

| TABLE_SCAN_SYSTEM | 22 | yes | ‘system’ to enable shell access |

| TABLE_SCAN_SH | 23 | yes | ‘sh’ to enable shell access |

| TABLE_SCAN_QUERY | 24 | yes | echo hex string to verify login |

| TABLE_SCAN_RESP | 25 | yes | utf8 version of query string |

| TABLE_SCAN_NCORRECT | 26 | yes | ‘ncorrect’ to fast-check for invalid password |

| TABLE_SCAN_PS | 27 | no | “/bin/busybox ps” |

| TABLE_SCAN_KILL_9 | 28 | no | “/bin/busybox kill -9 “ |

以上表格中只有TABLE_SCAN_PS和TABLE_SCAN_KILL_9进行了初始化而未对目标设备进行预执行操作。从20到26的操作均是在发送用户名和密码后的登录验证操作。其中TABLE_SCAN_CB_DOMAIN和TABLE_SCAN_CB_PORT为黑客配置的Load服务器,该服务器用于获取有效的Telnet扫描结果,扫描结果中包含IP地址、端口、Telnet用户名和密码等信息。发送信息的格式如下:

| zero(1个字节) | IP地址(4bytes) | 端口(2bytes) | 用户名长度(4bytes) | 用户名(muti-bytes) | 密码长度(4bytes) | 密码(muti-bytes) |

|---|

7、连接C&C,等候发动攻击

Mirai的攻击类型包含UDP攻击、TCP攻击、HTTP攻击以及新型的GRE攻击。其中,GRE攻击就是著名安全新闻工作者Brian Krebs的网站KrebsOnSecurity.com遭受的主力攻击形式,攻击的初始化代码如下:

C&C会被初始化在一张表中,当Mirai回连C&C时,会从表中取出C&C进行连接。

连接C&C成功后,Mirai会进行上线,其上线过程非常简单,自身简单向C&C发送4个字节的0。

接下来会等候C&C的控制命令,伺机对目标发动攻击。对于接受控制命令处做了一些处理,比如首先会进行试读来做预处理(控制指令长度判定等等),最后才会接受完整的控制命令。

当接受到控制命令后,Mirai对控制命令做解析并且执行。控制命令格式如下:

type Attackstruct {

Durationuint32

Typeuint8

Targetsmap[uint32]uint8 //Prefix/netmask

Flagsmap[uint8]string // key=value

}

其中,前4个字节为攻击时长,接下来的4个字节为攻击类型(攻击ID),然后是攻击目标,攻击目标格式如下:

| 目标数(4个字节) | IP地址(4个字节) | MASK(一个字节) | IP地址(4个字节) | MASK(一个字节) | IP地址….MASK… |

|---|

最后是Flags,Flag是一系列的键值对数据,结构类似于攻击目标的格式。下面列出Mirai僵尸网络攻击功能列表。

| 攻击类型(32位) | 类型值 | 攻击函数 |

|---|---|---|

| ATK_VEC_UDP | 0 | attack_udp_generic |

| ATK_VEC_VSE | 1 | attack_udp_vse |

| ATK_VEC_DNS | 2 | attack_udp_dns |

| ATK_VEC_UDP_PLAIN | 9 | attack_udp_plain |

| ATK_VEC_SYN | 3 | attack_tcp_syn |

| ATK_VEC_ACK | 4 | attack_tcp_ack |

| ATK_VEC_STOMP | 5 | attack_tcp_stomp |

| ATK_VEC_GREIP | 6 | attack_gre_ip |

| ATK_VEC_GREETH | 7 | attack_gre_eth |

| ATK_VEC_PROXY | 8 | attack_app_proxy(已经被取消) |

| ATK_VEC_HTTP | 10 | attack_app_http |

这其中的GRE攻击也就是9月20日安全新闻工作者Brian Krebs攻击事件的主力攻击类型。

scanListen分析

ScanListen主要用于处理bot扫描得到的设备信息(ip、端口、用户名、密码),并将其转化为如下格式后输入给Load处理。

Load分析

Load模块的主要功能是处理scanListen的输入并将其解析后针对每个设备实施感染。其感染实现方法如下:

(1)首先通过Telnet登陆目标设备。

(2)登陆成功后,尝试运行命令/bin/busybox ps来确认是否可以执行busybox命令。

(3)远程执行/bin/busybox cat /proc/mounts;用于发现可读写的目录。

(4)如果发现可用于读写的文件目录,进入该目录并将/bin/echo拷贝到该目录,文件更名为dvrHelpler,并开启所有用户的读写执行权限。

(5)接下来通过执行命令”/bin/busybox cat /bin/echo\r\n”来获取当前设备架构信息。

(6)如果获取架构信息成功,样本试图通过三种方式对设备进行感染,这三种方式分别为echo方式、wget方式、tftp方式。

(7)接下来通过Telnet远程执行下放的程序。

(8)最后远程删除bot程序。

总 结

僵尸网络已成为全球面临的共同问题,其攻击不同于其他以窃密、远控为主的恶意代码,其通过掌握着的巨型僵尸网络可以在任何时候对任何目标发动DDoS攻击。僵尸的感染对象已经从服务器、PC、智能手机,扩展向摄像头、路由器、家居安防系统、智能电视、智能穿戴设备,甚至是婴儿监视器,任何互联网连接的设备都可能成为一个潜在的目标。而一般用户是很难注意到被感染的状况的。Mirai僵尸由于源码的开放可能正在迅速的扩散,其攻击的流量特征也可能快速变化而难以监测。由于受感染目标多以IOT设备为主,所有的密码均固化在固件中,因此即便重启后Mirai从内存中消失也无法杜绝二次感染,并且隐藏在这种嵌入式设备中是极难判定其是否受到恶意感染。

缓解措施:

(1)如果感染Mirai,请重启设备,并且请求设备厂商更新固件剔除Telnet服务。

(2)不必要联网的设备尽量不要接入到互联网中。

(3)通过端口扫描工具探测自己的设备是否开启了SSH (22), Telnet (23)、 HTTP/HTTPS (80/443)服务,如果开启,请通知技术人员禁用SSH和Telnet服务,条件允许的话也可关闭HTTP./HTTPS服务(防止类似攻击利用Web对设备进行感染)。

Turn any hard drive into networked storage with Raspberry Pi

Networked hard drives are super convenient. You can access files no matter what computer you’re on — and even remotely.

But they’re expensive. Unless you use the Raspberry Pi.

If you happen to have a few of hard drives laying around you can put them to good use with a Raspberry Pi by creating your own, very cheap NAS setup. My current setup is two 4TB hard drives and one 128GB hard drive, connected to my network and accessible from anywhere using the Raspberry Pi.

Here’s how.

What you will need

For starters, you need an external storage drive, such as an HDD, SSD or a flash drive.

You also need a Raspberry Pi. Models 1 and 2 work just fine for this application but you will get a little better support from the Raspberry Pi 3. With the Pi 3, you’re still limited to USB 2.0 and 100Mbps via Ethernet. However, I was able to power one external HDD with a Pi 3, while the Pi 2 Model B could not supply enough power to the same HDD.

In my Raspberry Pi NAS, I currently have one powered 4TB HDD, one non-powered 4TB HDD and a 128GB flash drive mounted without issue. To use a Pi 1 or 2 with this, you may want to consider using a powered USB hub for your external drives or using a HDD that requires external power.

Additionally, you need a microSD card — 8GB is recommended — and the OpenMediaVault OS image, which you can download here.

Installing the OS

To install the operating system, we will use the same method used for installing any OS without NOOBS. In short:

- Format the SD card to FAT32 using SD Formatter.

- Download the image file from Sourceforge.

- Extract it using 7zip on Windows or The Unarchiver on Mac.

- Write the extracted image to the SD card using Win32 Disk Imager on Windows or ApplePi-Bakeron Mac.

More detailed installation instructions can be found here for both Windows and Mac. Just substitute the Raspbian image with OpenMediaVault.

Setup

After the image has been written to the SD card, connect peripherals to the Raspberry Pi. For the first boot, you need a keyboard, monitor and a local network connection via Ethernet. Next, connect power to the Raspberry Pi and let it complete the initial boot process.

Once that is finished, use the default web interface credentials to sign in. (By default, the username isadmin and the password is openmediavault.) This will provide you with the IP address of the Raspberry Pi. After you have that, you will no longer need a keyboard and monitor connected to the Pi.

Connect your storage drives to the Raspberry Pi and open a web browser on a computer on the same network. Enter the IP address into the address bar of the browser and press return. Enter the same login credentials again ( admin for the username and openmediavault for the password) and you will be taken to the web interface for your installation of OpenMediaVault.

Mounting the disks

The first thing you will want to do to get your NAS online is to mount your external drives. Click File Systems in the navigation menu to the left under Storage.

Locate your storage drives, which will be listed under the Device column as something like /dev/sda1 or/dev/sdc2. Click one drive to select it and click Mount. After a few seconds have passed, click Apply in the upper right corner to confirm the action.

Repeat this step to mount any additional drives.

Creating a shared folder

Next, you will need to create a shared folder so that the drives can be accessed by other devices on the network. To do this:

- Click Shared Folders in the navigation pane under Access Rights Management.

- Click Add and give the folder a name.

- Select one of the storage drives in the dropdown menu to the right of Volume.

- Specify a path (if you want it to be different from the name).

- Click save.

Enabling SMB/CFIS

Finally, to access these folders and drives from an external computer on the network, you need to enable SMB/CFIS.

Click SMB/CFIS under Services in the left navigation pane and click the toggle button beside Enable. Click Save and Apply to confirm the changes.

Next, click on the Shares tab near the top of the window. Click Add, select one of the folders you created in the dropdown menu beside Shared folder and click Save. Repeat this step for shared folders you created.

Accessing the drives over your network

Now that your NAS is up and running, you need to map those drives from another computer to see them. This process is different for Windows and Mac, but should only take a few seconds.

Windows

To access a networked drive on Windows, open File Explorer and click This PC. Select the Computer tab and click Map network drive.

In the dropdown menu beside Drive choose an unused drive letter. In the Folder field, input the path to the network drive. By default, it should look something like \\RASPBERRYPI\[folder name]. (For instance, one of my folders is HDD, so the folder path is \\RASPBERRYPI\HDD). Click Finish and enter the login credentials. By default, the username is pi and the password is raspberry. If you change or forgot the login for the user, you can reset it or create a new user and password in the web interface under User in Access Rights Management.

Mac

To open a networked folder in OS X, open Finder and press Command + K. In the window that appears, type smb://raspberrypi or smb://[IP address] and click Connect. In the next window, highlight the volumes you want to mount and click OK.

You should now be able to see and access those drives within Finder or File Explorer and move files on or off the networked drives.

There are tons of settings to tweak inside OpenMediaVault, including the ability to reboot the NAS remotely, setting the date and time, power management, a plugin manager and much, much more. But if all you need is a network storage solution, you’ll never need to dig any deeper.

微信教父张小龙所说的敏捷开发是什么?

微信教父张小龙所说的敏捷开发是什么?

昨天晚上,产品教父张小龙在WXG(微信事业群)领导力大会上的讲话又一次刷爆了互联网人的朋友圈。谈到敏捷开发的时候,张小龙直言:

我们今天可以想一些与众不同的点子,然后我们可以很快就看到效果,因为我们可以很快把它上线了,然后可以去验证,如果不对就下线,如果还有改进余地,下个星期再去改它。这是一个能够持续实现你的想法的过程。

其实这种敏捷开发的方法由来已久,并且被Google、Facebook等硅谷企业广泛应用。它已经形成了一套完整的方法论,总结起来就是“MVP”和“精益分析”两个概念。

一、敏捷的背后:MVP与精益分析

(一)MVP

MVP是最简化可实行产品(Minimum Viable Product)的简称。最简化可实行产品是以尽可能低的成本展现产品的核心概念,用最快、最简的方式建立一个可用的产品原型,用这个原型表达出你产品最终想要的效果,然后通过迭代来完善细节。

![]()

图1:MVP的产品迭代策略

假如你的产品愿景是一种高级出行工具,比如小轿车。传统的产品设计思路是一步一步,从车轮、车轱辘、外壳、动力装置、内部装饰一个流程一个流程做起,最后得到一个完善的产品。而MVP的思路,我们可能会先做一个小滑板车或者自行车,看看用户对出行工具的认可程度。如果用户认可我们的产品概念,我们可以接下去生产更加高级、完善的摩托车、甚至小轿车。

传统产品迭代思路成本高、速度慢、风险大,花高成本做出来的产品用户可能不认可;MVP策略的优点在于试错成本低、速度快、风险低,能满足产品快速迭代的需求。

(二)精益分析

埃里克·莱斯,硅谷著名的企业家和作家,最先提出来“精益创业”的概念。精益创业的理念涵括精益客户开发、精益软件开发和精益生产实践三大部分,这是一个快速和高效开发产品和服务的框架。

![]()

图2:”构建-衡量-学习“的精益分析框架

精益创业的本质是精益分析,核心是“构建-衡量-学习”循环。张小龙的敏捷开发想法和这个方法论不谋而合:首先是你有一个想法或者灵感,然后通过MVP策略产品快速上线;产品上线后,通过数据来衡量用户的表现,如果好的话就保持、继续优化,不好的下线反思。通过这种循环,产品快速迭代、用户的需求得到更好的满足。

二、数据驱动的MVP

在MVP开发过程或者精益分析整个框架中,最重要的莫属于衡量(measure)这个环节。如何选择合理的指标来衡量MVP的效果?如何通过合理工具来监测用户行为数据、优化产品?这都是敏捷开发需要解决的问题。

在精益化运营的今天,产品、市场、运营如何通过敏捷开发来提升效率,这是一个所有互联网人的需要面对的命题。

(一)产品:MVP

任何产品,信息量达到一个量级的时候就会出现信息查找困难的情况。一个装满文件的Mac笔记本,想找一个文档却不知道放在哪个文件夹了,这个时候就可以使用【Spotlight搜索】进行全局搜索。这样的好处,一个是能找到所有相关的文件,另一方面是节省时间。

![]()

图3:借鉴Mac笔记本的Spotlight搜索功能

某数据分析产品内含单图、看板、漏斗、分群等十多个功能模块,如何通过一次检索找到需要的图表就非常重要。因为这样可以避免个功能之间来回跳转,节省检索时间、提高效率。

1. 提出想法、快速构建

工程师提出做一个搜索工具的想法,方便用户在整个系统内进行全局搜索。产品经理根据用户反馈设定使用产品,把功能点进行优先级排序,确定MVP(最简化可实行产品)–––部分功能点击后直接进入详情页,降低操作成本。

2.产品落地、快速上线

工程师开始进行搜索库的建设,打通各个模块里的图表存储做为搜索库,匹配拼音/空格等多种搜索方式。设计师负责界面样式的设计,把信息直观地表现出来。

![]()

图4:GrowingIO的全局检索功能

3.数据验证、快速迭代

短短 1 天半的时间里,全局搜索产品快速迭代了三次。从只能把汉字作为关键字,到可以直接用拼音进行搜索,再把关键词和模块自动分类 ,提高整个搜索工具的检索速度。

在这次MVP实践中,快速组建团队、合理分工、快速上线验证起到了重要作用。团队越来越大的时候,我们需要跨部门更加直接的沟通、需要直接在白板前讨论的效率。这个【全局搜索】开发案例是一个非常好的MVP案例。

(二)营销:快速试错

商业环境变幻莫测,如何在竞争激烈的市场中赶超对手,这个时候快速、正确的决策尤为重要。

![]()

图5:GrowingIO分钟级别的实时数据监测

某在线教育产品正在探索获取用户的新方式,依次尝试了免费视频课程、赠送电子教材、热门话题在线讨论等多种方法,但是效果都一般般。某日该企业市场部门举行了一次免费在线直播课程,直播结束后的5分钟,该社区平台的流量比往日均值上涨了8倍,获取了大量新用户。实时监测到的数据极大启发了市场人员,直播流量会成为营销的新一轮增长点。

某互联网金融企业在SEM方面有大量的推广,但是他的CAC(获客成本)只有行业均值的一半,这到底是怎样做到的呢?在投放的初期,他们也面临着如何优化渠道、关键词等问题。在没有任何指导数据的基础上,他们对市场上的主流搜索引擎、相关关键词进行了一轮短时间的“地毯式轰炸”。

![]()

图6:GrowingIO监测到的广告效果

通过前期的地毯式投放,该企业获得了各个渠道、各个关键词的转化数据。通过数据分析,市场人员选出来转化效果最佳的两个渠道,进行大规模投放,并且在后期不断优化。通过这种方式该企业以非常低的成本获得了大量的新用户。

(三)运营:精益化

产品越来越多,同质化竞争越来越严重。产品要想在激烈的竞争中拔得头筹,除了产品设计,运营也是非常重要的一个因素。

某技术社区花了大量精力获取新用户,但是新用户的流失率一直居高不下,次周留存率才11%。一个偶然机会,一个新用户反馈给社区运营,说他们的精选文章非常好,他每天都看。

![]()

图7:GrowingIO留存图

受到这个启发,运营想既然精选文章能吸引新用户留下来,那是不是可以向新用户多多推荐精选内容呢?于是他们挑选了20篇优质文章拼凑成了一本PDF电子书,每位新注册用户都能收到这本电子书。数据显示,点击了这本电子书的用户次周留存率提升到了43%,这样的数据让社区运营人员异常兴奋。

![]()

图8:电子书MVP迭代过程

通过对读过电子书新用户的访谈,他们发现之前仓促准备的电子书内容不是适合所有人、而且内容深度不一,给很多新用户造成困恼。在接下来的几周时间里,该社区准备了前端、中端、后端、测试4个技术方向电子书,并且根据用户的工作时间推荐初级、中级、高级三个版本。一个月后,新版电子书向新用户推送,数据显示点击过电子书的新用户次周留存率再一次提升到了56%。

精益不是廉价或者小规模的代名词,精益意味着破除浪费、低效率并且快速行动起来,它适用于任何组织。MVP不仅是改善产品的方式,更是现实业务的监测器。

谈及之前所做的事,用张小龙自己的话说,“一个非常平庸的团队用了一些非常平庸的方法去做出来一个非常平庸的产品,而且是不知不觉的!”那么,如今的你为何不放手一搏。搭建一个志同道合的团队,尝试一下敏捷开发的方式,在不断试错中做出一个个惊艳的功能!

你,是不是也想试试?

10 Lessons Learned from Building Deep Learning Systems

10 Lessons Learned from Building Deep Learning Systems

Deep Learning is a sub-field of Machine Learning that has its own peculiar ways of doing things. Here are 10 lessons that we’ve uncovered while building Deep Learning systems. These lessons are a bit general, although they do focus on applying Deep Learning in a area that involves structured and unstructured data.

- The More Experts the Better

The one tried and true way to improve accuracy is to have more networks perform the inferencing and combining the results. In fact, techniques like DropOut is a means of creating “Implicit Ensembles” were multiple subsets of superimposed networks cooperate using shared weights.

2. Seek Problems where Labeled Data is Abundant

The current state of Deep Learning is that it works well only in a supervised context. The rule of thumb is around 1,000 samples per rule. So if you are given a problem where you don’t have enough data to train with, try considering an intermediate problem that does have more data and then run a simpler algorithm with the results from the intermediate problem.

3. Search for ways to Synthesize Data

Not all data is nicely curated and labeled for machine learning. Many times you have data that are weakly tagged. If you can join data from disparate sources to achieve a weakly labeled set, then this approach works surprisingly well. The most well known example is Word2Vec where you train for word understanding based on the words that happen to be in proximity with other words.

4. Leverage Pre-trained Networks

One of the spectacular capabilities of Deep Learning networks is that bootstrapping from an existing pre-trained network and using it to train into a new domain works surprisingly well.

5. Don’t forget to Augment Data

Data usually have meaning that a human may be aware of that a machine can likely never discover. One simple example is a time feature. From the perspective of a human the day of the week, whether this is a holiday or not or the time of the day may be important attributes, however a Deep Learning system may never be able to surface that if all its given are seconds since Unix epoch.

6. Explore Different Regularizations

L1 and L2 regularizations are not the only regularizations that are out there. Explore the different kinds and perhaps look at different regularizations per layer.

7. Embrace Randomness

There are multiple techniques to initialize your network prior to training. In fact, you can get very far just training the last layer of a network with the previous layers being mostly random. Consider using this technique to speed up you Hyper-tuning explorations.

8. End-to-End Deep Learning is a Hail Mary Play

A lot of researchers love to explore end-to-end deep learning research. Unfortunately, the most effective use of Deep Learning has been to couple it with out techniques. AlphaGo would not have been successful if Monte Carlo Tree Search was not employed. If you want to make an impact in the Academic community then End-to-end Deep Learning might be your gamble. However in a time constrained industrial environment that demands predictable results, then you best be more pragmatic.

9. Resist the Urge to Distribute

If you can, try to avoid using multiple machines (with the exception of hyper-parameter tuning). Training on a single machine is the most cost effective way to proceed.

10. Convolution Networks work pretty well even beyond Images

Convolution Networks are clearly the most successful kind of network in the Deep Learning space. However, ConvNets are not only for Images, you can use them for other kinds of features (i.e. Voice, time series, text).

That’s all I have for now. There certainly a lot more other lessons. Let me know if you stumble on others.

You can find more details of these individual lessons athttp://www.deeplearningpatterns.com

Originally published at blog.alluviate.com.

微博话题爬取与存储分析 一步步教你微博话题数据爬取与分析,以上海租房为例

微博话题爬取与存储分析

一步步教你微博话题数据爬取与分析,以上海租房为例

大数据社会下数据就是黄金,新浪微博作为一个国内网络社交早就意识到这一点,本着资本家和商人的心态给你提供的开放API接口只可以获得少量无关紧要的数据(想要数据,money来换),对比国外Twitte等社交平台会提供一些数据接口供研究人员获取大量研究数据。那我们GEEK的口号是,凡是网上能显示数据的朕兼“可取”(v_v…为什么加个引号呢,因为虽然出于技术角度是都可取得,但出于道德方面考虑也要尊重数据作者的规约)。

本文基于python以新浪微博为数据平台,从数据采集、关键字提取、数据存储三个角度,用最简单的策略来挖掘我们的“黄金”。

有爬虫基础的人可以直接跳过数据采集部分看“上海租房”话题挖掘实战项目,项目地址https://github.com/luzhijun/weiboSA(目前已更新豆瓣小组爬取)。

数据采集

使用python是因为代码简洁,虽然计算比java和c慢很多,但数据采集时间开销大部分是IO部分的,你愿意每次用java或者c写效率也提高不到哪去。

数据采集基本用爬虫机器人,原理谁都会,google就是靠他发家致富走上人生巅峰的。下面介绍常用来做爬虫的几个库。

Urllib

怎样抓网页呢?其实就是根据URL来获取它的网页信息,虽然我们在浏览器中看到的是一幅幅优美的画面,但是其实是由浏览器解释才呈现出来的,实质它是一段HTML代码,加 JS、CSS,如果把网页比作一个人,那么HTML便是他的骨架,JS便是他的肌肉,CSS便是它的衣服。所以最重要的部分是存在于HTML中的,下面我们就写个例子来扒一个网页下来。

import urllib2

response = urllib2.urlopen("http://www.baidu.com")

print response.read()

结果就和在Chrome等浏览器中右键查看源码一样的内容,urllib2是python内置库,简化了httplib的用法(urllib2.urlopen相当于Java中的HttpURLConnection)。有2那肯定有urllib啊,urllib2可以接受一个Request类的实例来设置URL请求的headers,但urllib仅可以接受URL。这意味着,你不可以伪装你的User Agent字符串等。urllib2在python3.x中被改为urllib.request。 接下来用urllib2伪装iphone 6浏览,模拟浏览器发送GET请求。

req = request.Request('http://www.douban.com/')

req.add_header('User-Agent', 'Mozilla/6.0 (iPhone; CPU iPhone OS 8_0 like Mac OS X) AppleWebKit/536.26 (KHTML, like Gecko) Version/8.0 Mobile/10A5376e Safari/8536.25')

with request.urlopen(req) as f:

print('Status:', f.status, f.reason)

print('Data:', f.read().decode('utf-8'))

结果会返回移动版的源码信息

...

<link rel="apple-touch-icon-precomposed" href="https://gss0.bdstatic.com/5bd1bjqh_Q23odCf/static/wiseindex/img/screen_icon.png"/>

<meta name="format-detection" content="telephone=no"/>

...

如果想要以post方式提交,只要在Request中附加data字段就可以,下面附加用户名密码登录新浪博客。

#我们模拟一个微博登录,先读取登录的邮箱和口令,然后按照weibo.cn的登录页的格式以username=xxx&password=xxx的编码传入:

from urllib import parse

print('Login to weibo.cn...')

email = input('Email: ')

passwd = input('Password: ')

login_data = parse.urlencode([

('username', email),

('password', passwd),

('entry', 'weibo'),

('client_id', ''),

('savestate', '1'),

('ec', ''),

('pagerefer', 'https://passport.weibo.cn/signin/welcome?entry=mweibo&r=http%3A%2F%2Fm.weibo.cn%2F')

])

req = request.Request('https://passport.weibo.cn/sso/login')

req.add_header('Origin', 'https://passport.weibo.cn')

req.add_header('User-Agent', 'Mozilla/6.0 (iPhone; CPU iPhone OS 8_0 like Mac OS X) AppleWebKit/536.26 (KHTML, like Gecko) Version/8.0 Mobile/10A5376e Safari/8536.25')

req.add_header('Referer', 'https://passport.weibo.cn/signin/login?entry=mweibo&res=wel&wm=3349&r=http%3A%2F%2Fm.weibo.cn%2F')

with request.urlopen(req, data=login_data.encode('utf-8')) as f:

print('Status:', f.status, f.reason)

for k, v in f.getheaders():

print('%s: %s' % (k, v))

print('Data:', f.read().decode('utf-8'))

其中Origin和referer字段是反“反盗链”,就是检查你发送请求的header里面,referer站点是不是他自己。

Cookielib

爬虫被封的一个依据就是重复IP,因此可以为爬虫设置不同代理IP。此外有些网站需要cookie才能查看,所谓Cookie,指某些网站为了辨别用户身份、进行session跟踪而储存在用户本地终端上的数据(通常经过加密)。比如说有些网站需要登录后才能访问某个页面,在登录之前,你想抓取某个页面内容是不允许的。那么我们可以利用Urllib2库保存我们登录的Cookie,然后再抓取其他页面就达到目的了。

cookielib模块的主要作用是提供可存储cookie的对象,以便于与urllib2模块配合使用来访问Internet资源。Cookielib模块非常强大,我们可以利用本模块的CookieJar类的对象来捕获cookie并在后续连接请求时重新发送,比如可以实现模拟登录功能。该模块主要的对象有CookieJar、FileCookieJar、MozillaCookieJar、LWPCookieJar。

它们的关系:CookieJar–派生->FileCookieJar –派生–>MozillaCookieJar和LWPCookieJar

from urllib import request

from http.cookiejar import CookieJar

cookie=CookieJar()

cookie_support= request.HTTPCookieProcessor(cookie)#cookie处理器

opener = request.build_opener(cookie_support)

opener.open('http://www.baidu.com')

for item in cookie:

print(item.name,':',item.value)

结果: >BAIDUID : E4DECD4AF63915B9AFF5AC28951A3DAA:FG=1

BIDUPSID : E4DECD4AF63915B9AFF5AC28951A3DAA

H_PS_PSSID : 1437_18241_17944_21079_18559_21454_21406_21377_21191_21321

PSTM : 1477631558

BDSVRTM : 0

BD_HOME : 0

这里使用默认的CookieJar 对象,如果要将Cookie保存起来,可以使用FileCookieJar类和其子类中的save方法,加载就用load方法。

写脚本从指定网站抓取数据的时候,免不了会被网站屏蔽IP。所以呢,就需要有一些IP代理。随便在网上找了一个提供免费IP的网站西刺做IP抓取。观察可以发现有我们需要的信息的页面url有下面的规律:www.xicidaili.com/nn/+页码。可是你如果直接通过get方法访问的话你会发现会出现500错误。原因其实出在这个规律下的url虽然都是get方法获得数据,但都有cookie认证,另外还有反外链等,下面例子用来获得西刺的cookie。

headers=[('User-Agent','Mozilla/6.0 (iPhone; CPU iPhone OS 8_0 like Mac OS X) AppleWebKit/536.26 (KHTML, like Gecko) Version/8.0 Mobile/10A5376e Safari/8536.25'),

('Host','www.xicidaili.com'),

('Referer','http://www.xicidaili.com/n')]

def getCookie()

cookie=CookieJar()

cookie_support= request.HTTPCookieProcessor(cookie)#cookie处理器

opener = request.build_opener(cookie_support)

opener.addheaders=headers

opener.open('http://www.xicidaili.com/')

return cookie

有了cookie就可以爬了,爬的内容怎么处理呢,介绍个SB工具—— BeautifulSoup。

BeautifulSoup

BeautifulSoup翻译叫鸡汤,现在版本是4.5.1,简称BS4,倒过来叫4SB,不过抓数据一点都不SB。提供一些简单的、python式的函数用来处理导航、搜索、修改分析树等功能。它是一个工具箱,通过解析文档为用户提供需要抓取的数据,因为简单,所以不需要多少代码就可以写出一个完整的应用程序。Beautiful Soup自动将输入文档转换为Unicode编码,输出文档转换为utf-8编码。你不需要考虑编码方式,除非文档没有指定一个编码方式,这时,Beautiful Soup就不能自动识别编码方式了。然后,你仅仅需要说明一下原始编码方式就可以了。 关于BS的介绍和用法官方文档很详细,下面给几个”Web scraping with python”1中的例子看下BS是否好喝,可以和文档对照看。 首先你得安装了BS,然后爬取http://www.pythonscraping.com/pages/page3.html中的图片来小试牛刀。

import re

from urllib import request

from bs4 import BeautifulSoup

html=request.urlopen("http://www.pythonscraping.com/pages/page3.html")

bs=BeautifulSoup(html,"lxml")

#打印所有图片地址

for pic in bs.find_all('img',{'src':re.compile(".*\.jpg$")}):

print(pic['src'])

结果: >../img/gifts/logo.jpg

>../img/gifts/img1.jpg

>../img/gifts/img2.jpg

>../img/gifts/img3.jpg

>../img/gifts/img4.jpg

>../img/gifts/img6.jpg

接上文,我们把西刺的高匿代理ip爬出来放到本地proxy.txt。

cookie=getCookie()

# get the proxy

with open('proxy.txt', 'w') as f:

for page in range(1,101):

if page%50==0:#每50页更新下cookie

cookie=getCookie()

url = 'http://www.xicidaili.com/nn/%s' %page

cookie_support= request.HTTPCookieProcessor(cookie)

opener = request.build_opener(cookie_support)

request.install_opener(opener)

req = request.Request(url,headers=dict(headers))

content = request.urlopen(req)

soup = BeautifulSoup(content,"lxml")

trs = soup.find('table',id="ip_list").findAll('tr')

for tr in trs[1:]:

tds = tr.findAll('td')

ip = tds[1].text.strip()

port = tds[2].text.strip()

protocol = tds[5].text.strip().

f.write('%s://%s:%s\n' % (protocol, ip, port))

结果十五秒爬了1万条数据(与电脑环境有关),说明1页正好100条,而总页数超过1000页,也就是记录数超过10w条,如果固定用同一个cookie肯定不安全(谁会有空翻看1000页数据。。。),因此设置每爬50页更新下cookie。 有了代理地址,不一定能保证有效,可能就被封杀了,因此使用思路是把代理地址存入哈希表,验证无效的删除(看状态码),重新在表中取新的记录。 代理地址使用方式如下:

...

proxy_handler = request.ProxyHandler({'http': '123.165.121.126:81'}) #http://www.xicidaili.com/nn/2 随便找个

opener = request.build_opener(proxy_handler,cookie_handler ...各种其他handle)

...

另外推荐个神器,crawlera ,基本满足各种需要。

假如真要爬1000页,需要花150秒?好吧,好像也不多,但我要说的是可以多进程或者异步处理。多进程很好做,注意以手动维护一个HttpConnection的池,然后每次抓取时从连接池里面选连接进行连接即可(每秒几百个连接正常的有理智的服务器一定会封禁你的)。python的异步处理用到了Twisted库,却远没有同是异步模式的nodejs火,算是python中的巨型框架了,想想python的巨型框架活的不久,感兴趣的推荐看下《Twisted网络编程必备》2。关于单线程、多线程、异步有张图推荐看下。

写爬虫还要考虑其他很多问题,授权验证、连接池、数据处理、js处理等,这里有个经典爬虫框架:Scrapy,目前支持python3,支持分布式, 使用 Twisted来处理网络通讯,架构清晰,并且包含了各种中间件接口,可以灵活的完成各种需求。

Scrapy与Pyspider

Scrapy的入门学习参见学习Scrapy入门,对应中文文档几小时内可以快速掌握。另外国内某大神开发了个WebUI的Pyspider,具有以下特性:

- python 脚本控制,可以用任何你喜欢的html解析包(内置 pyquery)

- WEB 界面编写调试脚本,起停脚本,监控执行状态,查看活动历史,获取结果产出

- 支持 MySQL, MongoDB, SQLite

- 支持抓取 JavaScript 的页面

- 组件可替换,支持单机/分布式部署,支持 Docker 部署

- 强大的调度控制

从内容上讲,两者具有功能差不多,包括以上3,5,6。不同是Scrapy原生不支持js渲染,需要单独下载scrapy-splash,而PyScrapy内置支持scrapyjs;PySpider内置 pyquery选择器,Scrapy有XPath和CSS选择器,这两个大家可能更熟一点;此外,Scrapy全部命令行操作,Pyscrapy有较好的WebUI;还有,scrapy对千万级URL去重支持很好,采用布隆过滤来做,而Spider用的是数据库来去重?最后,PySpider更加容易调试,scrapy默认的debug模式信息量太大,warn模式信息量太少,由于异步框架出错后是不会停掉其他任务的,也就是出错了还会接着跑。。。从整体上来说,pyspider比scrapy简单,并且pyspider可以在线提供爬虫服务,也就是所说的SaaS,想要做个简单的爬虫推荐使用它,但自定义程度相对scrapy低,社区人数和文档都没有scrapy强,但scrapy要学习的相关知识也较多,故而完成一个爬虫的时间较长。

因为比较喜欢有完整文档的支持,所以后面主要用Scrapy,简要说下Scrapy运行流程。

- 首先,引擎从调度器中取出一个链接(URL)用于接下来的抓取

- 引擎把URL封装成一个请求(Request)传给下载器,下载器把资源下载下来,并封装成应答包(Response)

- 然后,爬虫解析Response

- 若是解析出实体(Item),则交给实体管道进行进一步的处理。

- 若是解析出的是链接(URL),则把URL交给Scheduler等待抓取

根据scrapy文档描述,要防止scrapy被禁用,主要有以下几个策略。

- 动态设置user agent

- 禁用cookies

- 设置延迟下载

- 使用 Google cache

- 使用IP地址池( Tor project 、VPN和代理IP)

- 使用 Crawlera

由于Google cache基于你懂的原因不可用,其余都可以利用,Crawlera的分布式下载,我们可以在下次用一篇专门的文章进行讲解。下面主要从动态随机设置user agent、禁用cookies、设置延迟下载和使用代理IP这几个方式入手。

自定义中间件

Scrapy下载器通过中间件控制的,要实现代理IP、user agent切换可以自定义个中间件。 在项目下创建(如何创建项目,使用scrapy start yourProject命令,参考文档)好项目后,在里面找到setting.py文件,先把agents和代理ip放到setting.py中(代理ip较少情况下这样做,较多的话还是放到数据库中去,方便管理),设置中间件名字MyCustomSpiderMiddleware和优先级。

USER_AGENTS = [

"Mozilla/4.0 (compatible; MSIE 6.0; Windows NT 5.1; SV1; AcooBrowser; .NET CLR 1.1.4322; .NET CLR 2.0.50727)",

"Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0; Acoo Browser; SLCC1; .NET CLR 2.0.50727; Media Center PC 5.0; .NET CLR 3.0.04506)",

"Mozilla/4.0 (compatible; MSIE 7.0; AOL 9.5; AOLBuild 4337.35; Windows NT 5.1; .NET CLR 1.1.4322; .NET CLR 2.0.50727)",

"Mozilla/5.0 (Windows; U; MSIE 9.0; Windows NT 9.0; en-US)",

"Mozilla/5.0 (compatible; MSIE 9.0; Windows NT 6.1; Win64; x64; Trident/5.0; .NET CLR 3.5.30729; .NET CLR 3.0.30729; .NET CLR 2.0.50727; Media Center PC 6.0)",

"Mozilla/5.0 (compatible; MSIE 8.0; Windows NT 6.0; Trident/4.0; WOW64; Trident/4.0; SLCC2; .NET CLR 2.0.50727; .NET CLR 3.5.30729; .NET CLR 3.0.30729; .NET CLR 1.0.3705; .NET CLR 1.1.4322)",

"Mozilla/4.0 (compatible; MSIE 7.0b; Windows NT 5.2; .NET CLR 1.1.4322; .NET CLR 2.0.50727; InfoPath.2; .NET CLR 3.0.04506.30)",

"Mozilla/5.0 (Windows; U; Windows NT 5.1; zh-CN) AppleWebKit/523.15 (KHTML, like Gecko, Safari/419.3) Arora/0.3 (Change: 287 c9dfb30)",

"Mozilla/5.0 (X11; U; Linux; en-US) AppleWebKit/527+ (KHTML, like Gecko, Safari/419.3) Arora/0.6",

"Mozilla/5.0 (Windows; U; Windows NT 5.1; en-US; rv:1.8.1.2pre) Gecko/20070215 K-Ninja/2.1.1",

"Mozilla/5.0 (Windows; U; Windows NT 5.1; zh-CN; rv:1.9) Gecko/20080705 Firefox/3.0 Kapiko/3.0",

"Mozilla/5.0 (X11; Linux i686; U;) Gecko/20070322 Kazehakase/0.4.5",

"Mozilla/5.0 (X11; U; Linux i686; en-US; rv:1.9.0.8) Gecko Fedora/1.9.0.8-1.fc10 Kazehakase/0.5.6",

"Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/535.11 (KHTML, like Gecko) Chrome/17.0.963.56 Safari/535.11",

"Mozilla/5.0 (Macintosh; Intel Mac OS X 10_7_3) AppleWebKit/535.20 (KHTML, like Gecko) Chrome/19.0.1036.7 Safari/535.20",

"Opera/9.80 (Macintosh; Intel Mac OS X 10.6.8; U; fr) Presto/2.9.168 Version/11.52",

]

PROXIES = [

{'ip_port': '111.11.228.75:80', 'user_pass': ''},

{'ip_port': '120.198.243.22:80', 'user_pass': ''},

{'ip_port': '111.8.60.9:8123', 'user_pass': ''},

{'ip_port': '101.71.27.120:80', 'user_pass': ''},

{'ip_port': '122.96.59.104:80', 'user_pass': ''},

{'ip_port': '122.224.249.122:8088', 'user_pass': ''},

]

# 禁用cookoe (enabled by default)

COOKIES_ENABLED = False

#设置下载延迟

DOWNLOAD_DELAY = 1

# 下载中间件

# See http://scrapy.readthedocs.org/en/latest/topics/downloader-middleware.html

DOWNLOADER_MIDDLEWARES = {

'weiboZ.middlewares.MyCustomDownloaderMiddleware': 543,

}

middlewares/MyCustomDownloaderMiddleware.py

import random

import base64

from settings import PROXIES

class RandomUserAgent(object):

"""Randomly rotate user agents based on a list of predefined ones"""

def __init__(self, agents):

self.agents = agents

@classmethod

def from_crawler(cls, crawler):

return cls(crawler.settings.getlist('USER_AGENTS'))

def process_request(self, request, spider):

#随机选个agent

request.headers.setdefault('User-Agent', random.choice(self.agents))

class ProxyMiddleware(object):

def process_request(self, request, spider):

proxy = random.choice(PROXIES)

if proxy['user_pass'] is not None:

request.meta['proxy'] = "http://%s" % proxy['ip_port']

encoded_user_pass = base64.encodestring(proxy['user_pass'])

request.headers['Proxy-Authorization'] = 'Basic ' + encoded_user_pass

else:

request.meta['proxy'] = "http://%s" % proxy['ip_port']

互联网道德和规约

当你准备爬某个网站的时候,首先应该先看下该网站有没有robots.txt。robots.txt是1994年出现的,也称为机器人排除标准(Robots Exclusion Standard),网站管理员不想某些内容被爬到的时候可以再该文件中注明。robots.txt虽然有主流的语法格式,但是各大企业标准不一,没有别人可以阻止你创建自己版本的robots.txt,但这些robots.txt不应该因为不符合主流而不被遵守。一般文件字段包含:User-agent,Allow,Disallow分别代表搜索机器人允许看和不许看的内容。

之前看新闻说今年4月大众点评把百度给告了,请求法院判令两被告停止不正当竞争行为,共同赔偿汉涛公司经济损失9000万元和为制止侵权行为支出的45万余元,并刊登公告、澄清事实消除不良影响。有用百度地图的应该知道这个(最近百度高德开撕,又在黑百度了~~~),定位完毕会显示附近商家和点评信息,来看下大众点评网的robots.txt. 光看

User-agent: *

…

Disallow: /shop//rank_p

…

就知道不允许任何企业和个人爬他家的商店评分数据,更何况其他更具有价值的数据呢,数据是黄金,要求赔偿9000万元对百度来说不算多,但百度回应内容大众点评网的robots协议面向百度等搜索引擎开放,百度地图抓取大众点评网的内容正是在robots.txt允许的情况下。通常业内习惯上没有被不允许的就是允许的,也就是说网站的关键信息可以帮助SEO优化的这个不能被禁止哟,不然你就没头条了,看人家竞争对手爱帮网倒是单独被列出来全面封杀了,因为其实力太弱,没有商业合作价值。就算这样我也没看出允许百度抓点评的用户评论数据,难道说点评网之前没robots.txt?人家不傻!百度挖了人家数据还叫嚣着遵守Robots协议,(其实他完全可以偷偷摸摸抓了数据自己私下研究,却要直接在百度地图上显示出来,这是要把数据价值榨干啊,够霸道)好比把人打了顿理直气壮地说你瞅啥一样,太野蛮了。。。

说多了,来看下新浪微博的Robots协议。明确规定了Sitemap: http://weibo.com/sitemap.xml 中列出的内容不允许被百度、360、谷歌、搜狗、微软必应、好搜、神马查看,后面还注明了Disallow: User-agent: * Disallow: /,也就是说前面是单独列出的,理论上这些数据不允许任何机构和个人爬取。这些是啥数据呢,movie和music数据,那你放心好了,微博文本数据可以爬了,但人家也不傻,可以显示的微博信息是有限制的,不可能所有数据库的数据都显示出来。

实战

在58、赶集、链家上找过房子的人都为中介苦恼,所谓的行业规矩令人做呕,这些人不生产社会价值却担当了新世纪的买办角色,好在通过微博也可以找房,而且绝大部分是个人房源。

以上海找房子为例,微博搜索框输入@上海租房 就可以的到如下页面 >http://s.weibo.com/weibo/%2540%25E4%25B8%258A%25E6%25B5%25B7%25E7%25A7%259F%25E6%2588%25BF?topnav=1&wvr=6&b=1

还是不错的,然后看下源码发现并没有html数据,显然是AJAX异步了,Scrapy要爬的话还得安装scrapy-splash改下配置用splash解析js内容,而且要看下一页必须登录状态才可以,那要在header里面添加cookie,可以登录后chrome F12 开发工具查看,但你敢保证拿包含自己的账号的cookie去做爬虫发现了不被封?其实这里可以显示的数据最多1000条,按最新的1000条显示,何必大费周章去搞那么复杂呢,可以用移动版的微博搜下嘛,点击。

用开发者工具看下网络请求数据状况,搜索包含名字‘page’ 请求消息头,可以发现规律:

左边Name列凡是内容页下拉引起ajax加载新页,新页内容以json格式返回;右边字段末尾page=?部分,代表传递第几页的内容,?最大到100,和电脑版最多看50页一样有数据限制。

json内容如下:

ok,能显示的数据都在里面,而且还是json格式,都不用选择器了,这个要比电脑版简单多了。

数据提取(ETL)

选择需要的数据

并不是所有json字段的数据都有用,这里只选取有用的字段,总的原则是按需抽取。可以看下项目中定义的Items.py。

微博内容id 对应字段放数据库中将有唯一约束,防止重复微博。选择mblogid作为唯一id,而千万不是itemid,经测试发现itemid只代表当天微博的槽位,比如限制浏览10条数据,就有1~10个槽位,而itemid就代表这10个槽位标签,并不代表微博内容id。另外mblog字段下还有个id属性,估计和mblogid一样的效果,有兴趣可以试试。

发布时间代表信息的实效,json里面有两个字段表示,一个是时间戳created_timestamp,另一个是显示出来的真实时间数据,这里取真实数据方便直接提取显示,但后期存储的时候需要统一转换为标准时间格式。

评论数、转发数、点赞数和时效结合可以用来综合评估微博信息价值(时间越靠后这三个数字越能评价信息价值)。

用户名、粉丝数、说说数可以用来检验用户是否有价值用户,或者是机器人。

后期处理需要提取求/租信息的关键词,包含价格、几号线、行政区划、信息是求租还是出租。

项目中定义的pipelines.py文件是scrapy管道处理类,也就是主要的后期数据处理类。其中一个是JsonPipeline类,直接将数据打印到json文件中,这个前期可以用来调试爬虫效果。另一个是MongoPipeline类,用来保存后期处理后的数据。在setting文件中ITEM_PIPELINES属性可以设置具体采用哪个管道处理类。

后期处理主要任务是提取关键字,如何从微博信息中爬取地理位置、价格?这里采用双数组Trie树

DAT

Trie树是搜索树的一种,来自英文单词”Retrieval”的简写,可以建立有效的数据检索组织结构,是中文匹配分词算法中词典的一种常见实现。它本质上是一个确定的有限状态自动机(DFA),每个节点代表自动机的一个状态。在词典中这此状态包括“词前缀”,“已成词”等。前面文章讲了下其原理,可以查看。

采用Trie树搜索最多经过n次匹配即可完成一次查找(即最坏是0(n)),而与词库中词条的数目无关,缺点是空间空闲率高,它是中文匹配分词算法中词典的一种常见实现。

双数组Trie(doublearrayTrie,DAT)是trie树的一个简单而有效的实现(日本人发明的),由两个整数数组构成,一个是base[],另一个是check[]。双数组Trie树是Trie树的一种变形,是在保证Trie树检索速度的前提下,提高空间利用率而提出的一种数据结构.其本质是一个确定有限状态自动机(DeterministicFiniteAutomaton,DFA),每个节点代表自动机的一个状态,根据变量的不同,进行状态转移,当到达结束状态或者无法转移时完成查询.DAT采用两个线性数组(base和check)对Trie树保存,base和check数组拥有一致的下标,即DFA中的每一个状态,也即Trie树中所说的节点,base数组用于确定状态的转移,check数组用于检验转移的正确性,检验该状态是否存在34。

在比较用于正向最大匹配分词的速度方面,DAT分词平均速度为936kB/s5(2006年),项目用到github上一日本人的python版的DAT,其查询速度可以达到 2.755M/s,查询速度和分词速度基本是差不多的,这三倍的差距应该是做了优化的。

词典的收集是比较麻烦,没有现成的,项目中搜集了上海地铁、街道、行政区、乡镇等信息,其中价格信息范围是从600~9000,可识别二千、二千二、两千一等中文价格,后面微博上看到有人用1.2k做价格的,暂时没加入,自己可以加入词条后重新运行下makeData.py文件即可收录。

判断信息是租房还是求房也是根据关键字,当信息中出现[“求租”, “想租”,”求到”,”求从”, “要租”, “寻租”,”寻找”, “找新房子”, “找房子”, “找房”, “寻房”, “求房”, “想找”, “希望房”]信息就标注为求房,否则标注为租房。

此外项目还收集了三千多个楼盘信息,由于有些楼盘信息容易混淆真实语境,比如‘峰会’(真不懂怎么会有这楼盘名)、‘艺品’与信息‘文艺品味’、‘黄兴’、‘金铭’与人名冲突等等。有想根据楼盘查询信息的同学可以把makeData.py中第5、51行注释取消运行下这个文件。

关于时间处理,微博挖到的时间有几种类型:

- 2016年01月01日 00点00分

- 1月1日 00:00

- 今天 00:00

- 1分钟前/11分钟前

- 10秒前

需要统一转化,使用DataUtil类处理。其中mongodb使用的是ISO时间,比北京时间早8小时,而pymongo中的datetime.datetime 数据并不会按时区处理,因此手动减少8小时后存储。同样从mongoDB中取出的时间要转化为当地时间。

> d=new Date()

> d

ISODate("2016-10-29T06:59:49.461Z")

> d.toLocaleDateString()

10/29/2016

数据存储

其实就这点数据放哪个数据库都无所谓,但假如这个数据量很大,就要好好考虑数据存储了。

选择oracle、mysql 还是 nosql

数据库的比较就好比java、c#、python、Go等的骂战一样,没有最好的,只有最适合场景的。oracle、mysql都学过,nosql中学过hbase和mongodb,就我而言单从7个角度比较:

- 功能:oracle>mysql> nosql

- 写性能:noSql>oracle≈≈mysql

- 简单查询: oracle>mysql>nosql

- 复杂查询(含join): oracle>mysql>nosql

- 架构扩展: noSql>mysql>oracle

- 可维护性: oracle>mysql>nosql

- 成本: oracle>mysql≈≈nosql

对于现在这个场景,爬虫在前端爬数据,管道层在那边处理数据后写数据,而这些数据具有时效性,也就是说只会去读一部分数据,相对来说,这就对写的要求较高。此外,这个场景就一个表,不涉及多表关联、约束等,复杂查询可以说没有,需要功能较少。另外网络数据不能保证一致性和可靠性,只要高可用性(HA)即可,Nosql可以设置副本机制达到高可用性,mysql虽然也可以做到成本稍高,将来可扩展角度也不适合。因此这个场景最适合的是Nosql。

Hbase 还是Mongodb

Cassandra HBase和MongoDb性能比较此文详细比较了三种主流Nosql数据库,最终项目选择Mongodb,就在于MongoDB适合做读写分离场景中的读取场景,并且其用js开发的,对json插入支持特别好。什么时候mongodb是较坏的选择呢,参考WHY MONGODB IS A BAD CHOICE FOR STORING OUR SCRAPED DATA

python的mongodbSDK包叫pymongo,十分钟看个教程就会了,这个业务场景为了加快查询,需要对价格、行政区、发布时间创建索引,其中价格、行政区由于是数组形式所以是多键索引,索引属性是稀疏的,即不允许空值。此外对这条微博的mblog_id加个唯一索引。索引在初始运行时创建,之后除非手动删除数据库后运行,否则不会再创建。

为保证每次插入的数据都是最新的,插入前应比较数据的发布时间与数据库中的最新时间,如果是早的说明已经爬过的,不需要插入。

关于mongodb的使用文档,点这里。